В начале 2026 года криптоаналитика переживает заметный сдвиг. Финансовые платформы всё чаще используют рассуждающие языковые модели, которые не просто выдают прогноз, а показывают ход мысли. Для разработчиков и дата-сайентистов это меняет саму логику работы с риском и неопределённостью.

Речь идёт о LLM с цепочками рассуждений, способных связывать ончейн-активность, сетевые метрики и рыночные признаки в единую интерпретируемую картину. Такой подход особенно важен на фоне усложнения экосистемы блокчейнов, где простые корреляции давно перестали работать.

В новостной повестке эти модели всё чаще описываются не как «чёрные ящики», а как аналитические слои поверх данных. Именно это делает тему актуальной для инженерного сообщества, работающего на стыке ИИ и финансов.

Ончейн-сигналы и их представление

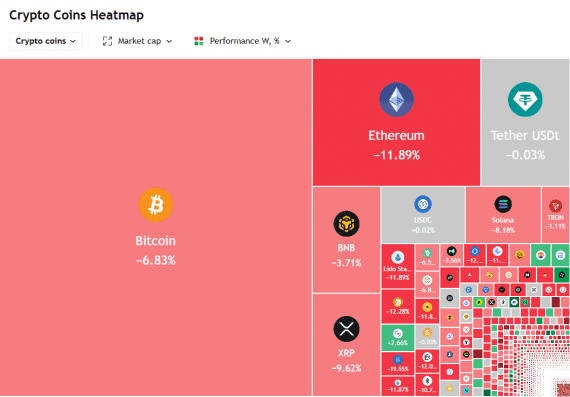

Одна из ключевых задач — корректное представление ончейн-сигналов для последующего рассуждения модели. Активность адресов, потоки между кластерами кошельков, метрики вроде TVL или MVRV сами по себе разрозненны и шумны. Поэтому перед подачей в LLM они агрегируются в транзакционные графы и временные окна с выверенной семантикой.

На этом уровне уже формируется пользовательский нарратив. Платформы всё чаще показывают не сырые графики, а текстовые сводки, которые объясняют, почему модель выделяет тот или иной паттерн. В результате вопросы прикладного характера, вроде того, как формируются подсказки наподобие какую криптовалюту купить сегодня, опираются не на интуицию, а на структурированное описание данных. При этом такие формулировки остаются аналитическими, а не директивными, что снижает регуляторные и этические риски.

Рассуждение LLM над финансовыми признаками

Следующий слой — собственно рассуждение над финансовыми признаками. В отличие от классических ML-моделей, reasoning-LLM выстраивают цепочку: от изменения сетевой активности к возможному влиянию на ликвидность и далее к рыночному настроению. Этот процесс можно отследить и проанализировать.

Для инженеров это означает возможность дебага не только данных, но и логики вывода. Если модель делает неожиданный вывод, команда видит, на каком шаге возник перекос. Такой подход повышает доверие к системе и упрощает интеграцию в сложные продуктовые пайплайны.

Ограничения и риски обобщения

Однако интерпретируемость не отменяет ограничений. Цепочки рассуждений могут усиливать скрытый bias, если исходные ончейн-данные агрегированы некорректно. Ошибка на раннем этапе масштабируется на весь вывод, создавая иллюзию логически выверенного, но неверного анализа.

Кроме того, LLM склонны к обобщениям на основе исторических паттернов. В условиях резких рыночных сдвигов это может приводить к запаздывающим интерпретациям. Поэтому в инженерной практике всё чаще применяются data-centric подходы с постоянной переоценкой признаков.

Практическая ценность для аналитиков

Для аналитиков и разработчиков главный эффект — смещение роли модели. Рассуждающие LLM становятся интеллектуальными помощниками, которые готовят контекст, подсвечивают связи и формируют объяснимые сводки. Окончательное решение по-прежнему остаётся за человеком.

В более широком смысле это сближает ИИ и финансовую аналитику на уровне языка. Когда модель умеет объяснять, она становится частью диалога, а не источником догм. Для экосистемы криптоплатформ это означает более прозрачные продукты и более осознанную работу с данными.