DeepMath-103K: датасет для обучения с подкреплением моделей рассуждения от Tencent

21 апреля 2025

DeepMath-103K: датасет для обучения с подкреплением моделей рассуждения от Tencent

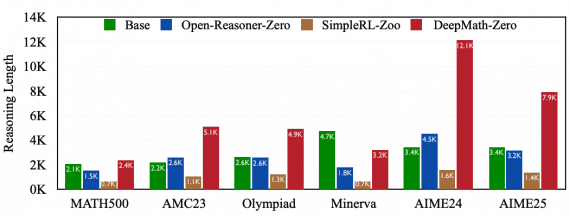

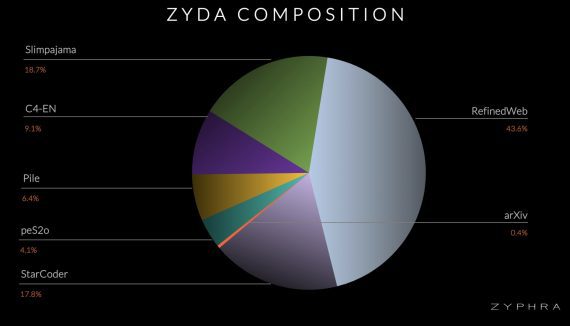

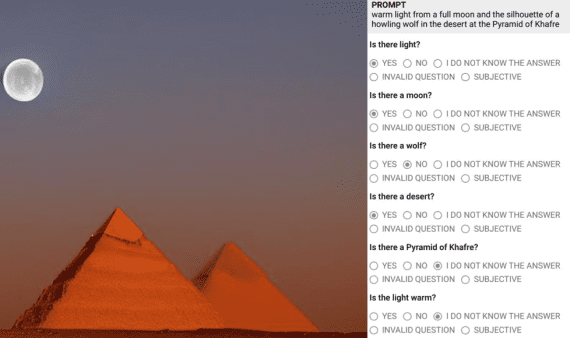

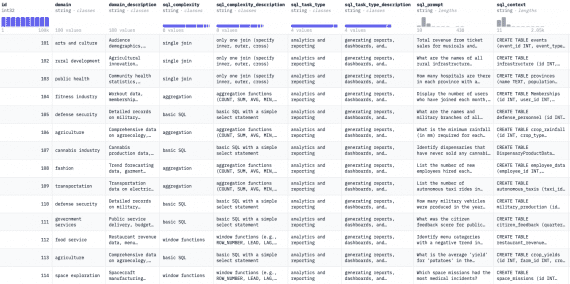

Исследователи из Tencent и Шанхайского университета Цзяо Тонг опубликовали DeepMath-103K — крупный математический датасет, созданный для разработки продвинутых моделей рассуждения с помощью обучения с подкреплением. Создание набора данных стоило исследователям…