Nemotron Nano 2 9B: модель от NVIDIA обходит Qwen3-8B на бенчмарках, работает в 6 раз быстрее и поддерживает контекст 128k

20 августа 2025

Nemotron Nano 2 9B: модель от NVIDIA обходит Qwen3-8B на бенчмарках, работает в 6 раз быстрее и поддерживает контекст 128k

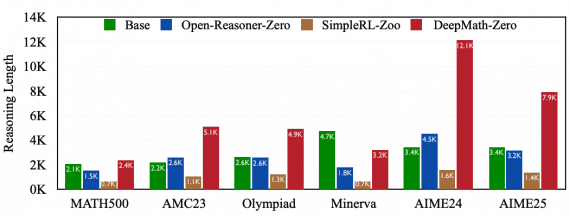

Команда исследователей NVIDIA представила Nemotron-Nano-9B-v2 — гибридную Mamba-Transformer языковую модель, которая выдает ответы в 6 раз быстрее Qwen-3-8B на задачах рассуждения, превосходя ее в точности. Модель с 9 миллиардами параметров…