Фреймворк TreeQuest: адаптивные команды LLM превосходят отдельные модели на 30%

8 июля 2025

Фреймворк TreeQuest: адаптивные команды LLM превосходят отдельные модели на 30%

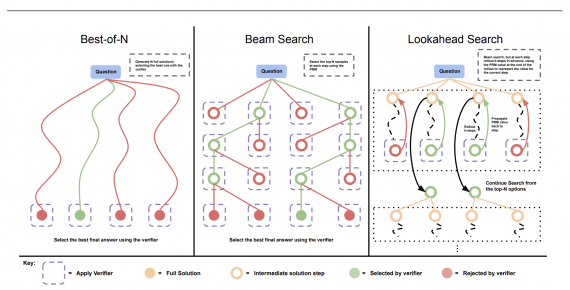

Исследователи из Sakana AI представили Adaptive Branching Monte Carlo Tree Search (AB-MCTS) — революционный подход к созданию «команд мечты» из больших языковых моделей, который позволяет им динамически сотрудничать для решения…