Масштабирование вычислений на этапе инференса может увеличить производительность в 14 раз

27 августа 2024

Масштабирование вычислений на этапе инференса может увеличить производительность в 14 раз

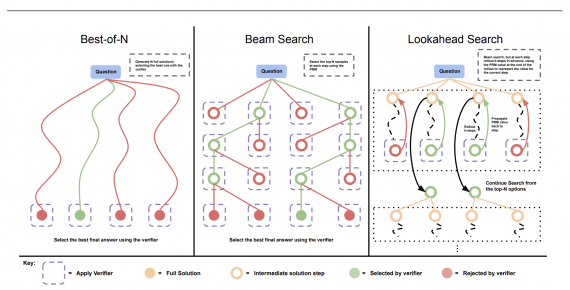

Исследователи из UC Berkeley и Google DeepMind предложили новый метод оптимизации вычислений на этапе инференса для LLM и продемонстрировали, что увеличение вычислительных мощностей на этапе инференса может быть более эффективным,…