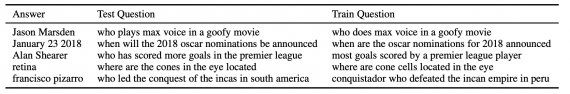

Задача open domain вопросно-ответных систем предполагает, что модель умеет отвечать на новые вопросы с помощью знаний, выученных во время обучения. Кроме того, модель должна уметь генерализовать имеющиеся знания для ответа на новые вопросы. Однако результаты на тестовом наборе данных не показывают реальное качество моделей. Исследователи в FAIR проанализировали топ-3 популярных open domain QA датасета. В 60-70% ответы на вопросы в тестовой выборке были в обучающей выборке. Кроме того, 30% тестовых вопросов имели дубликат в обучающей выборке. Затем исследователи протестировали state-of-the-art модели. Скор всех моделей падал значительно ниже, когда необходимо было дать ответ на вопрос, которого напрямую не было в обучающем сете. Среднее различие в точности предсказания между повторяющимися и неповторяющимися данными было 63%.

Подробнее про анализ

Датасеты, которые анализировали исследователи, включали в себя Natural Questions, TriviaQA и WebQuestions.

WebQuestions

WebQuestions — это датасет из 3,778 обучающих и 2,032 тестовых пар вопросов и ответов. Вопросы вытащили из поисковой системы, а ответы — из Freebase.

TriviaQA

TriviaQA — это датасет из 78,785 обучающих, 8,837 валидационных и 11,313 тестовых пар вопросов и ответов. Создатили соскрепили вопросы и ответа с сайтов с викторинами.

Open-Natural Questions

Natural Questions состоит из вопросов из поисковой системы и ответов из Википедии. В обучающей, валидационной и тестовой выборках было 79,168, 8,757 и 3,610 пар вопросов и ответов.

Перед тем как искать пересечения ответов в выборках, исследователи нормализовали ответы. Пересечения вопросов определяли частично вручную с помощью разметки перефраза. Подробнее о методе поиска пересечений можно почитать в оригинальной статье.