Robustness Gym — это открытая библиотека для оценки стабильности NLP-моделей. Библиотека объединяет и унифицирует 4 аспекта устойчивости моделей: субпопуляция, трансформации, тестовые наборы данных и состязательные атаки. Robustness Gym позволяет исследователям сравнивать результаты 4 тестов, разрабатывать свои методы оценки стабильности моделей и делиться ими. Библиотеку разрабатывали исследователи из Salesforce Research и Stanford Hazy Research.

Зачем это нужно

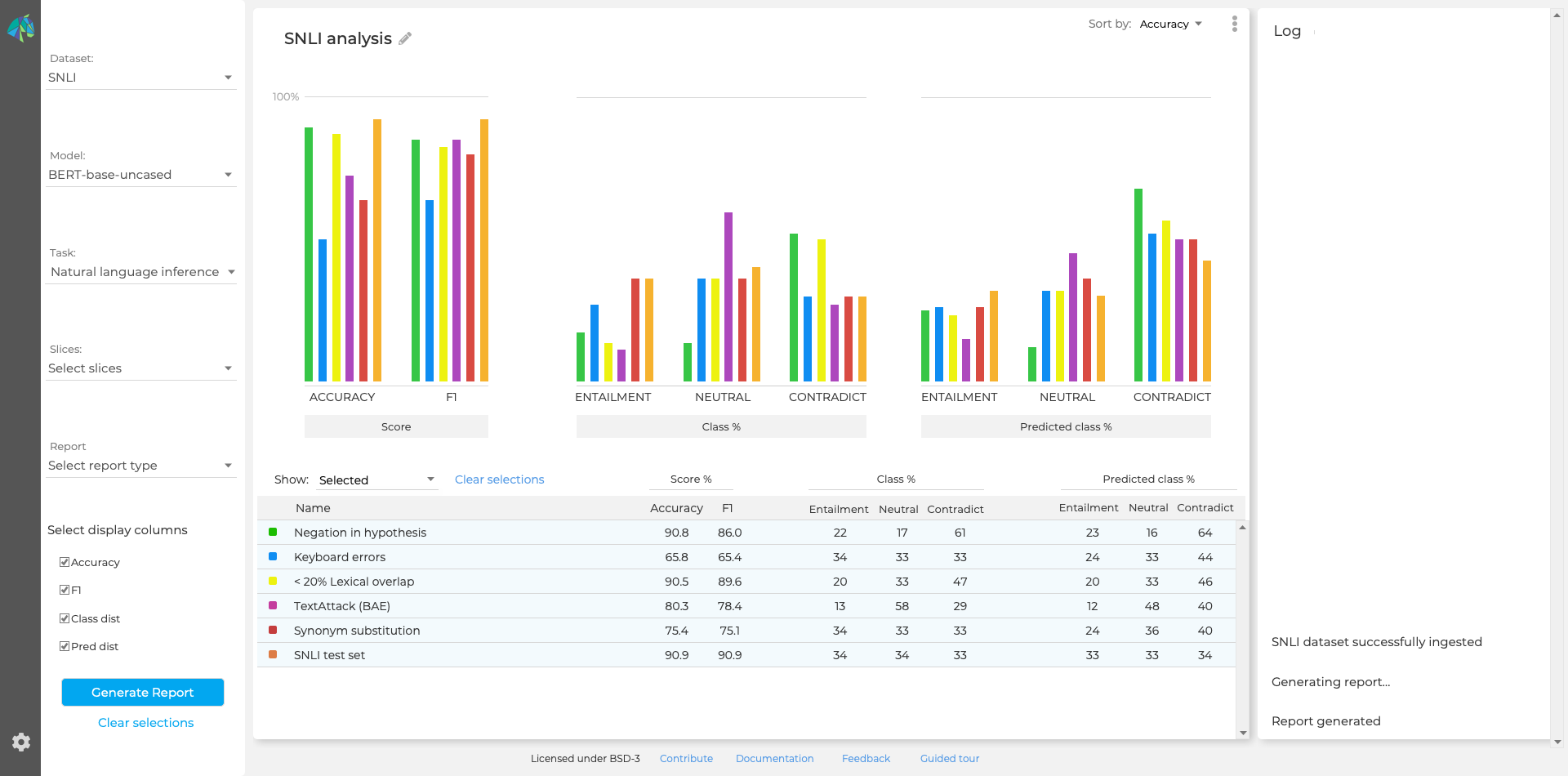

Несмотря на успехи моделей обработки естественного языка на стандартных датасетах, нейросети часто не справляются с данными из реальной жизни. Это связано со сдвигами в распределении данных, артефактам из обучающей выборки и шумом в данных. Robustness Gym призвана оценивать, насколько модель уязвима в отношении перечисленных особенностей реальных данных. Библиотека поддерживает весь спектр методологий оценки стабильности моделей.

Тестирование библиотеки

Чтобы оценить потенциальную полезность Robustness Gym для исследователей, разработчики провели кейс-стади с командой по предсказанию сентиментальной окраски текста. Разработчики также сравнивали state-of-the-art коммерческие решения для связывания именованных сущностей (NEL) и для суммаризации с академическими реализациями моделей. Подробнее о результатах тестирования и о самом инструменте — в оригинальной статье.