GraphTransformer — это расширение Transformer языковой модели для графовых данных.

Зачем это нужно

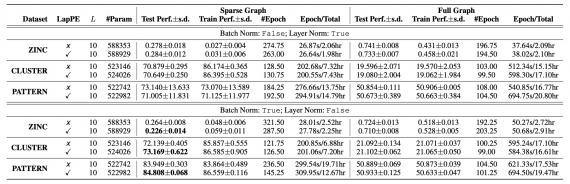

Оригинальный трансформер разрабатывали для обработки естественного языка. Стандартная модель работает с полносвязными графами, которые представляют связи между словами (токенами) в последовательности. Такая архитектура не масштабируется на задачи обработки графов и плохо справляется с задачами, где важна топология графа. Исследователи предлагают расширение традиционного трансформера с четырьмя отличительными характеристиками.

Подробнее про архитектуру

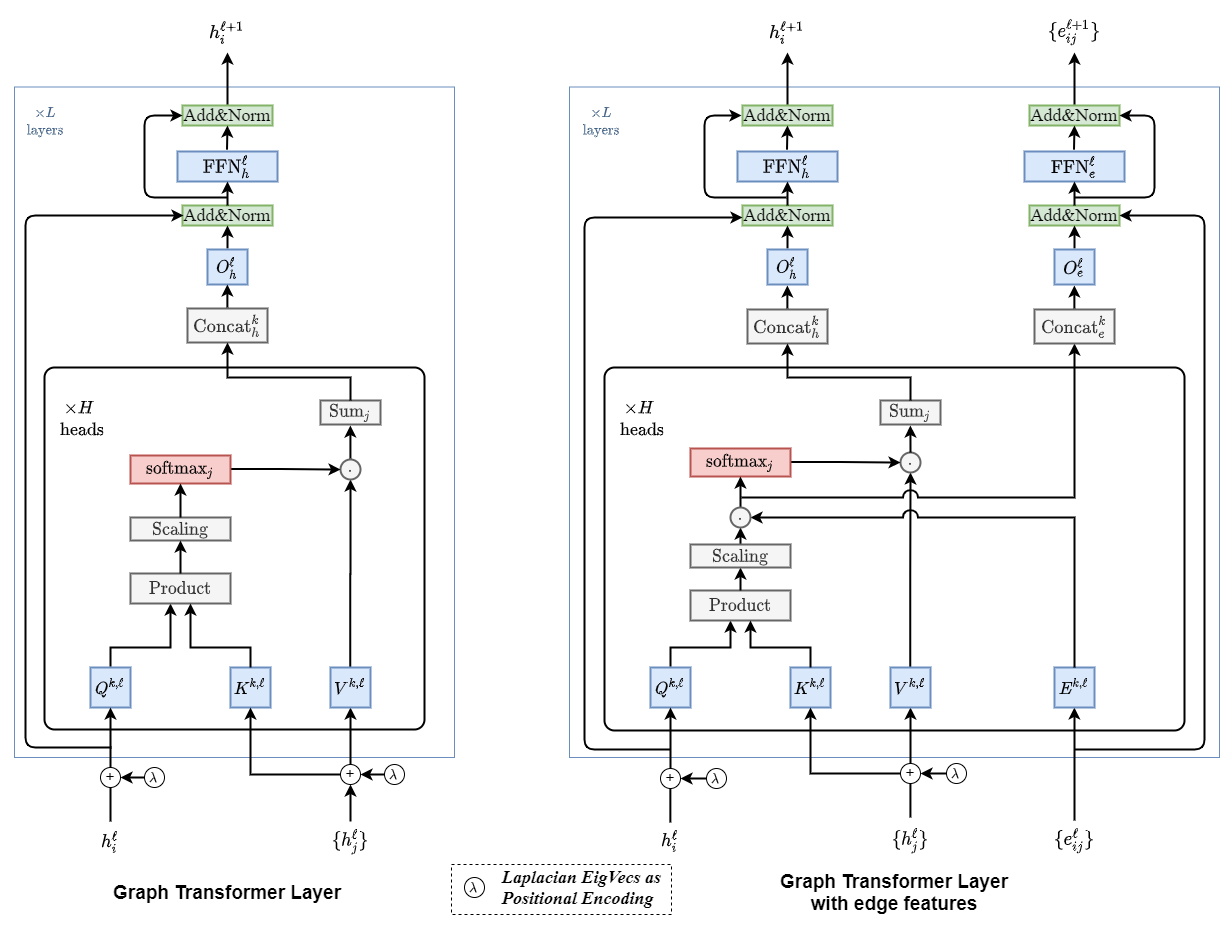

В сравнении со стандартной архитектурой Transformer, которая адаптирована под обработку текстовых данных, предложенная архитектура отличаются следующим:

- Механизм внимания — это функция соседства (neighborhood connectivity) для каждой ноды в графе;

- Кодирование позиции реализовано через Laplacian eigenvectors, которые являются обобщением синусоидального позиционного кодирования, которое часто используют в NLP;

- Нормализация слоев заменена на батч нормализацию слоев;

- Архитектура расширена так, что в ней теперь есть представление ребер. Это может быть критично для задач, которые богаты информацией о связях