REALM — это метод для предобучения языковых моделей. С помощью REALM из предобученной модели можно извлекать знания о мире напрямую из сырых документов. При этом модели не нужно хранить факты в весах. Суть подхода в том, что модель представления слов обучается совместно с моделью извлечения знаний. Исследователи опубликовали код проекта для репликации экспериментов.

Описание проблемы

Последние достижения в обработке естественного языка во многом опирались на предобучение без учителя. Языковая модель обучается на большом наборе текстов общей тематики. В таком случае разметка данных не требуется. Такие предобученные модели, как BERT или RoBERTa, хранят в себе существенный набор знаний о мире, который подчерпнут из обучающей выборки. Кодирование знаний особенно важно для таких задач, как вопросно-ответные системы, извлечение информации и генерация текста. Однако существующие модели хранят знания имплицитно в весах. Это усложняет проверку наличия знаний в модели и процесс их поиска.

Исследователи предлагают метод для предобучения, который позволяет обращаться к знаниям модели напрямую без увеличения размера модели или её сложности. Для этого исследователи используют референсный корпус текстов.

Как работает REALM

Стандартным подходом для предобучения является заполнение пропущенных слов. Однако знания о мире, которые модель выучивает во время предобучения, абстрактные и к ним нельзя получить прямой доступ.

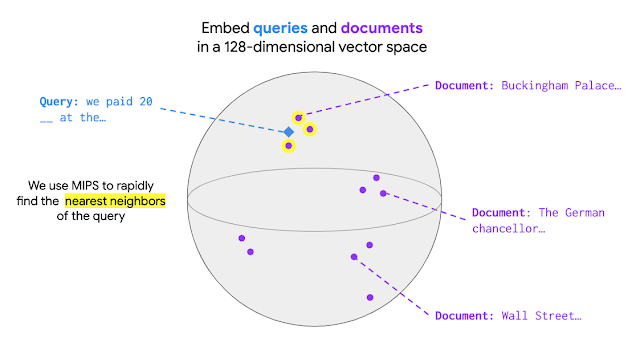

Альтернативный подход, который предлагают исследователи, — это дополнительно обучать ещё и модель извлечения знаний (knowledge retriever). Такая модель сначала извлекает текст из внешнего набора данных, чтобы дать языковой модели больше контекста для заполнения пропусков. Если извлечённая информация не помогает языковой модели при заполнении пробелов, тогда модель извлечения наказывается. Модель извлечения знаний также обучается с целевой функцией заполнения пропущенных слов. В качестве стороннего корпуса исследователи в своих экспериментах использовали тексты английской Википедии.

Оценка работы подхода

Исследователи сравнили T5, предобученную стандартным способом и с помощью REALM на задаче Open-QA. По результатам экспериментов, REALM модель с 300 миллионами параметров на 4 пункта обходит T5 c 11 миллиардами параметров.