Команда исследователей из Center for AI Safety и Scale AI опубликовала Remote Labor Index (RLI) — первый бенчмарк, который проверяет, могут ли ИИ-агенты делать настоящую работу фрилансеров. Они собрали 240 реальных проектов с Upwork — от создания игр до архитектурных чертежей. Результаты показывают, что даже самые продвинутые ИИ выполняют только 2.5% задач на уровне, приемлемом для заказчика. Это довольно неожиданно, учитывая, насколько хорошо ИИ показывают себя на других бенчмарках. Проект частично открытый. Исследователи опубликовали код платформы оценки и 10 примеров проектов на Github, чтобы все могли посмотреть, как это работает. Но основной тестовый набор из 230 проектов держат в секрете — это стандартная практика для бенчмарков, чтобы компании не могли «подогнать» свои модели под конкретные задачи. Если опубликовать всё, то модели выучат эти проекты наизусть, и тест станет бесполезным.

Как устроен бенчмарк

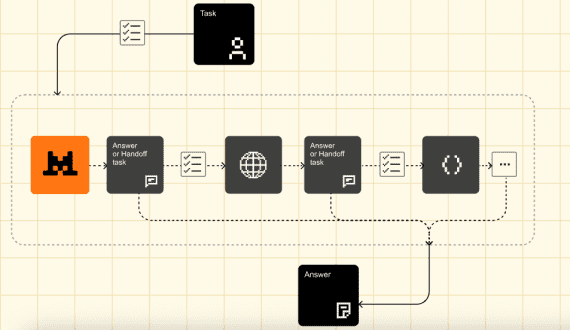

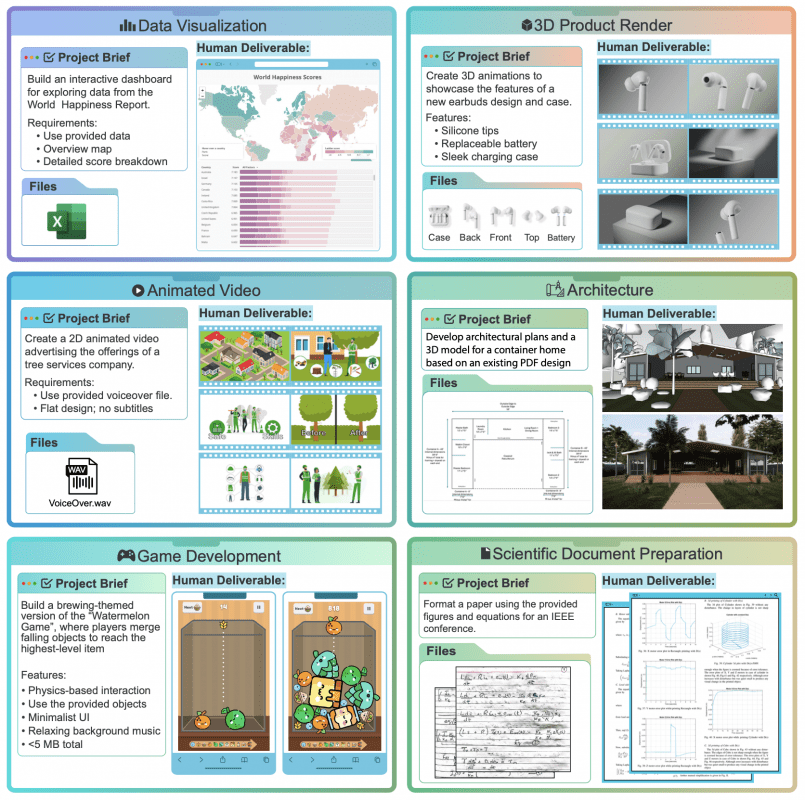

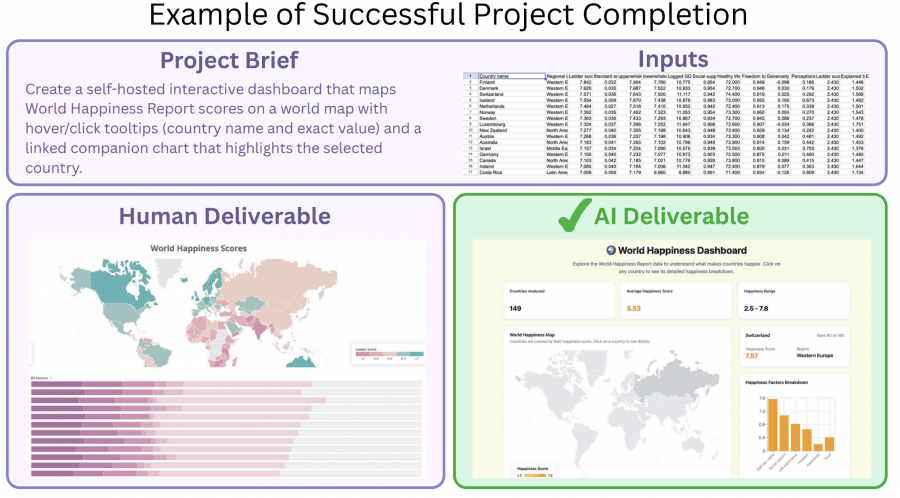

В отличие от обычных бенчмарков, где ИИ решает абстрактные задачки, RLI использует реальные проекты с фриланс-бирж. Исследователи находили фрилансеров на Upwork и платили им $15-200 за примеры уже выполненных работ. Каждый такой проект состоит из трёх частей: техническое задание от клиента, исходные файлы для работы и готовый результат, который фрилансер когда-то сдал и за который получил деньги.

Схема сбора данных была такой: когда-то реальный заказчик дал задание фрилансеру, тот выполнил работу, клиент остался доволен и заплатил. Спустя время исследователи купили у фрилансера копию этого проекта. Теперь для теста они дают то же самое задание и те же файлы ИИ и смотрят, сможет ли он сделать работу такого же качества. Работа профессионала тут играет роль «правильного ответа» — это подтверждённая рынком планка качества, которую реальный заказчик счёл достойной оплаты.

Исследователи собрали проекты двумя способами: 207 штук купили через обычные заказы у фрилансеров на Upwork, а ещё 40 добавили из редких категорий работ и нашли в открытом доступе (с разрешения авторов). Проекты охватывают 23 категории работ: видео и анимация (13%), 3D-моделирование (12%), графический дизайн (11%), создание игр (10%), аудио (10%), архитектура (7%) и дизайн продуктов (6%). В среднем за проект платят $632, хотя половина стоит $200 или меньше, а на выполнение уходит около 29 часов (медиана — 11.5 часов). В сумме все 240 проектов — это больше 6,000 часов работы стоимостью свыше $140,000.

Что получилось у ИИ

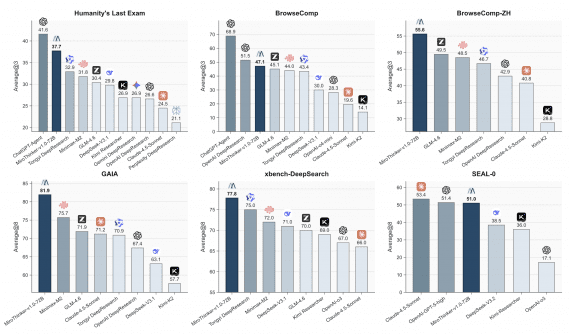

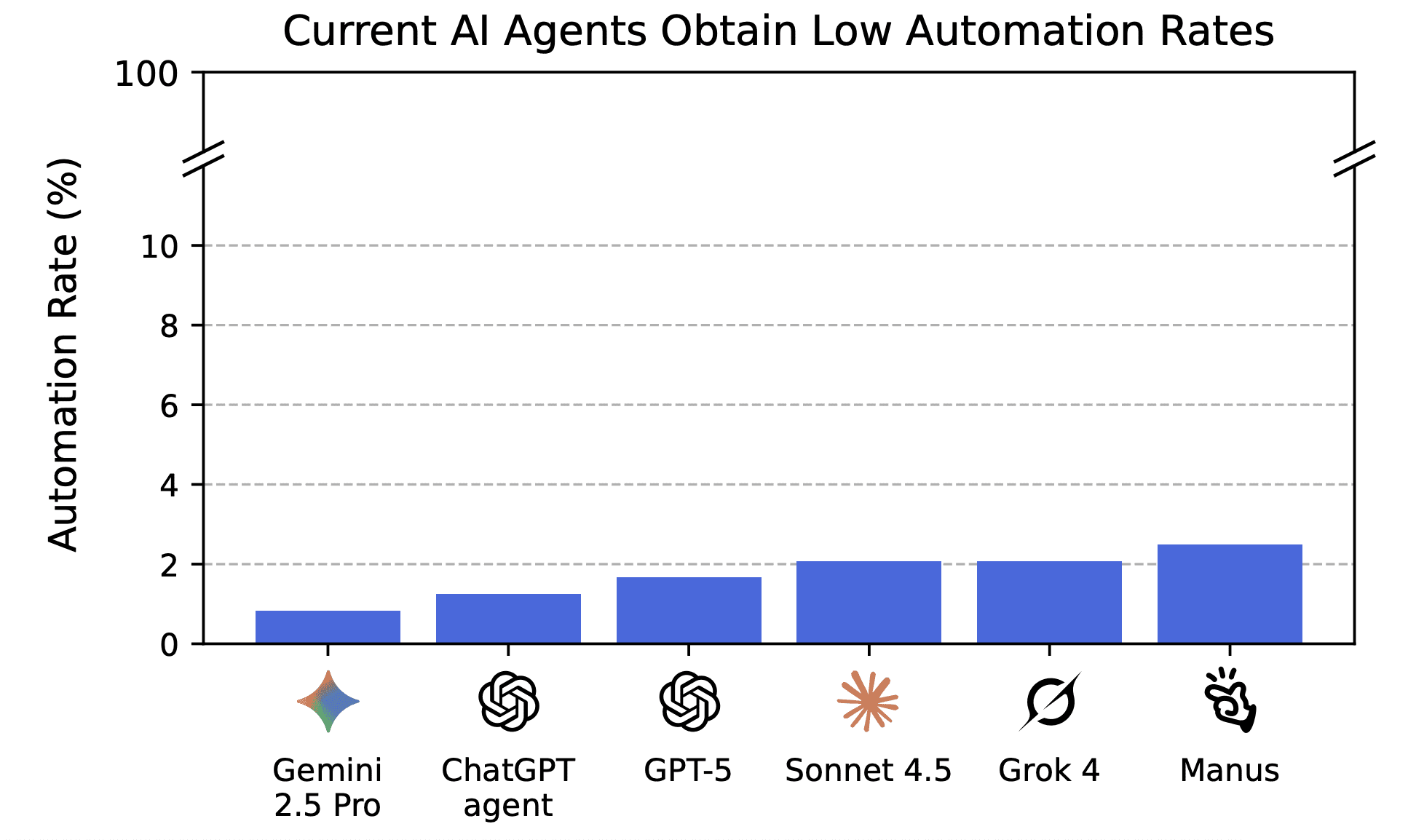

Протестировали шесть моделей: Manus, Grok 4, Claude Sonnet 4.5, GPT-5, ChatGPT agent и Gemini 2.5 Pro. Лучше всех справился Manus — по 2.5% проектов, на втором месте Grok 4 и Sonnet 4.5 с 2.1%. По рейтингу Elo снова лидирует Manus с 509,9 баллами, но это всё равно намного ниже человеческого уровня в 1000 баллов. Разница в 400 баллов примерно означает, что человек выиграет у ИИ с вероятностью 10 к 1.

Когда разобрали типичные ошибки, выяснилось несколько паттернов. В 17.6% случаев ИИ создавал битые или пустые файлы. В 35.7% работа была незаконченной — например, видео длиной 8 секунд вместо 8 минут. В 45.6% случаев качество было просто плохим — примитивные рисунки с использованием базовых геометрических форм вместо профессиональной графики или роботизированные голоса в озвучке. И в 14.8% случаев разные части работы не соответствовали друг другу — например, дом выглядел по-разному на разных 3D-рендерах.

В чём ИИ уже неплохи

Небольшое количество проектов ИИ всё-таки выполнили хорошо. Это в основном творческие задачи с аудио и изображениями, плюс написание текстов и простое программирование. Конкретно: редактирование аудио (создание звуковых эффектов для ретро-игры, отделение вокала от музыки, склейка озвучки с музыкой), генерация картинок для рекламы и логотипов, написание отчётов и создание интерактивных дашбордов с данными. Тут модели показали результат сравнимый или даже лучше человеческого.

Многие провалы связаны с тем, что ИИ не умеют проверять свою работу. Особенно это заметно в проектах, где нужна сложная визуальная проверка — архитектура, создание игр, веб-разработка. Модель может сгенерировать 3D-дом или игру, но не понимает, когда что-то работает неправильно или выглядит странно.

Почему RLI лучше других бенчмарков

RLI сильно отличается от других бенчмарков. Проекты тут в среднем занимают в два раза больше времени, чем в похожих тестах вроде HCAST и GDPval, и это соответствует реальным заказам на Upwork. Ещё важнее — распределение типов работ. Существующие бенчмарки в основном проверяют программирование и исследования с написанием текстов, а в реальности на фриланс-биржах много других задач: дизайн, операционная работа, маркетинг, администрирование, обработка данных, аудио-видео продукция.

По разнообразию форматов файлов RLI тоже впереди — 72 уникальных типа против 24 в GDPval: 3D-модели (.obj, .stl, .gltf), CAD-чертежи (.dwg, .dxf, .skp), дизайнерские файлы (.psd, .ai), архитектурные форматы (.rvt, .ifc) и много мультимедиа. Платформа для оценки умеет открывать все эти форматы прямо в браузере, включая интерактивные 3D-модели и WebGL-игры.

Экономика автоматизации

Кроме обычных метрик, исследователи придумали autoflation — насколько дешевле стало выполнить все проекты из теста, если использовать ИИ там, где он справляется. К октябрю 2025 года это снижение составило 4%. Звучит немного, но это только начало. Ещё считали dollars earned — сколько «заработал» каждый ИИ на успешно выполненных проектах. Лидер Manus получил бы $1,720 из возможных $143,991, если бы работал фрилансером.

Запуск ИИ на одном проекте стоил в среднем $2.34 (с лимитом $30 на API), что намного дешевле человеческой работы. Интересно, что стоимость проекта и время выполнения сильно коррелируют (0.785 на логарифмической шкале) — чем дороже проект, тем дольше его делают, что логично. Самые дешёвый проект стоил $9, самые дорогой — $22,500, а распределение близко к логнормальному, как в реальной экономике.

Что не вошло в тест

RLI покрывает не всю удалённую работу. Исключили задачи, где нужно общаться с клиентом (репетиторство), работать в команде (менеджмент проектов) или ждать результата (SEO-продвижение). Цены на проекты взяты исторические, без поправки на инфляцию — реально эта работа сейчас стоит дороже. И даже если ИИ выполнит все 240 проектов идеально, это не значит, что он справится со всеми типами удалённой работы, которые существуют.

Главный вывод: несмотря на то, что ИИ отлично справляются с академическими тестами на знания и логику, до реальной работы фрилансера им ещё очень далеко. RLI даёт конкретные цифры для отслеживания прогресса, и эти цифры помогут компаниям и государствам готовиться к тому, как ИИ изменит рынок труда. Датасет будут расширять новыми проектами, а методологию адаптировать под улучшающиеся модели.