Show-o2: открытая мультимодальная 7B модель обходит 14B-модели на бенчмарках, используя в разы меньше данных для обучения

26 июня 2025

Show-o2: открытая мультимодальная 7B модель обходит 14B-модели на бенчмарках, используя в разы меньше данных для обучения

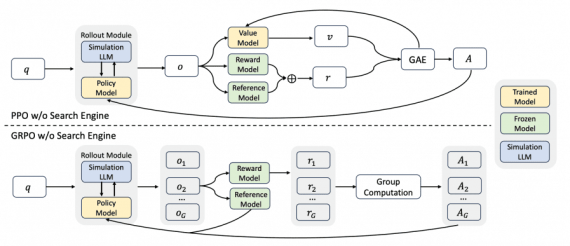

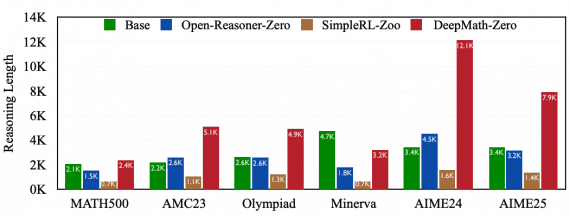

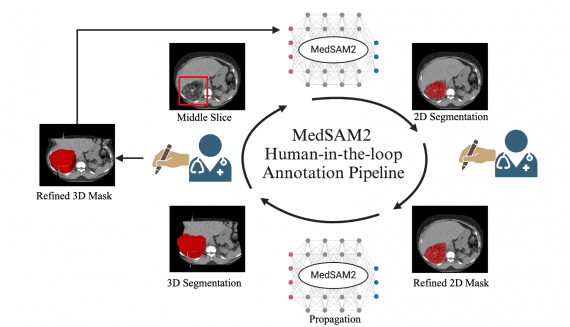

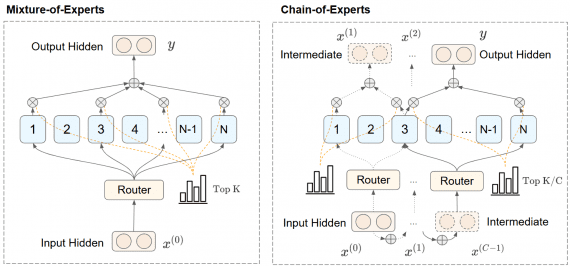

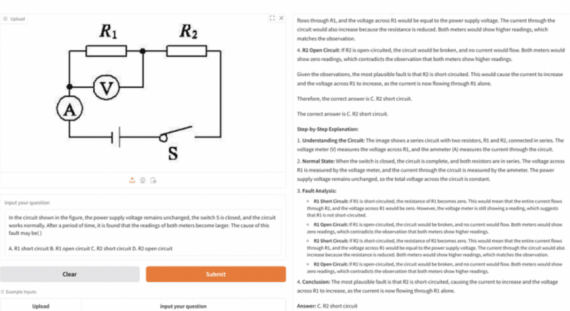

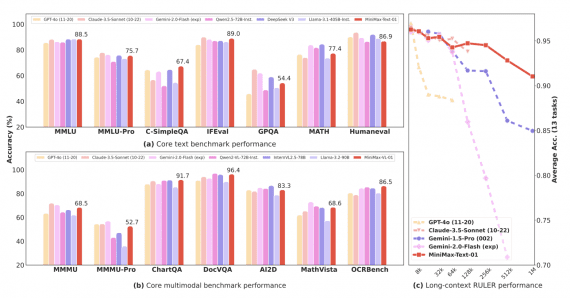

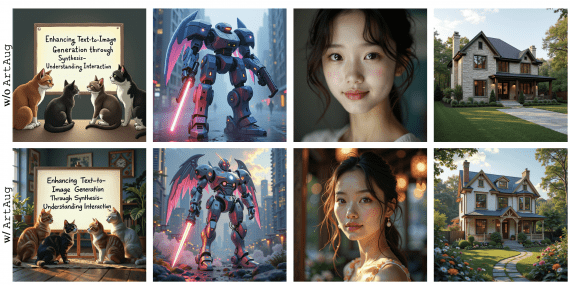

Исследователи из Show Lab Национального университета Сингапура и ByteDance представили Show-o2 — второе поколение мультимодальной модели, которая демонстрирует превосходные результаты в задачах понимания и генерации изображений и видео. Show-o2 использует…