Исследователи из Salesforce обучили языковую модель восстанавливать структуру белка. В качестве архитектуры использовали state-of-the-art языковую модель BERT. Помимо модели, разработчики публикую инструмент для трехмерной визуализации механизма внимания обученной модели.

Модель, которая была обучена предсказывать скрытую аминокислоту в последовательности белка, восстанавливает высокоуровневые структурные и функциональные характеристики протеина. Исследователи выяснили, что языковая модель использует механизм внимания для двух целей:

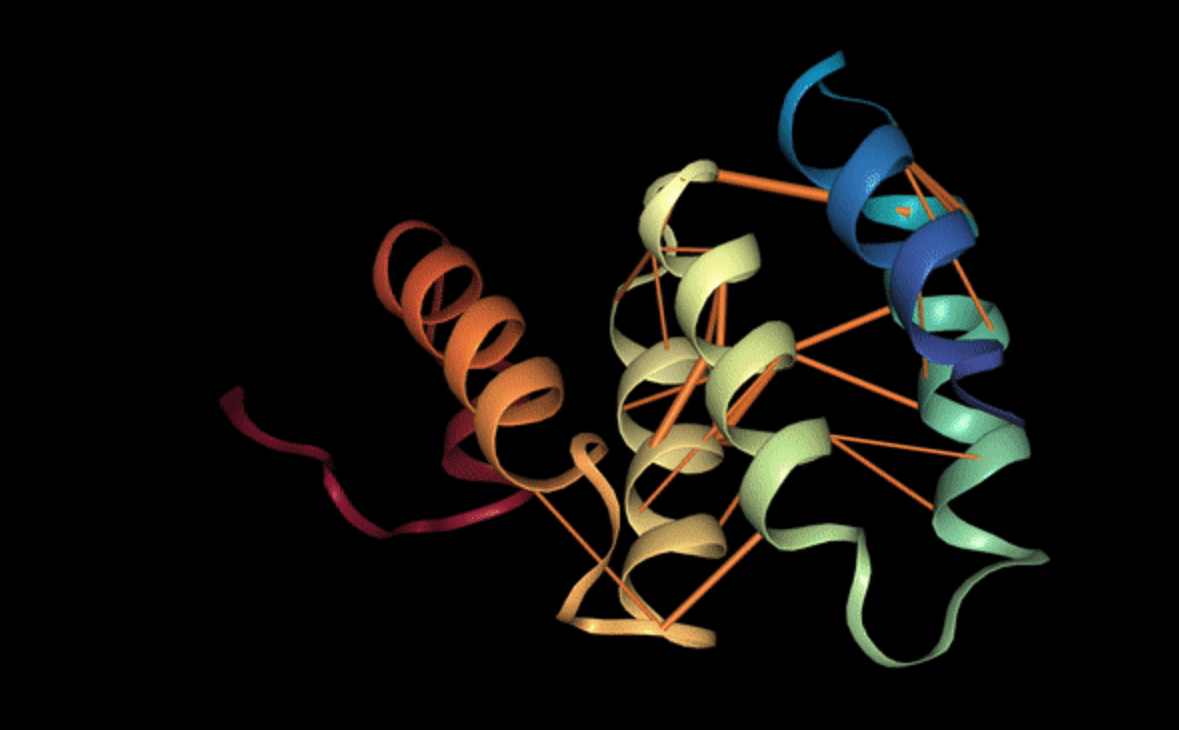

- Выявить складную структуру протеинов, сцепляя регионы, которые отдалены в последовательности, но в пространстве близки;

- Распознать сайты связывания, которые являются ключевым функциональным компонентом протеинов

Как это работает

Протеины — это сложные молекулы, которые играют важную функциональную и структурную роль в организмах живых существ. Несмотря на сложность поведения протеинов, их представления является простым. Каждый протеин можно представить как цепь из аминокислот.

Если представлять протеины как последовательности дискретных символов (аминокислот), то к ним применимы привычные языковые модели, которые используются в NLP. Исследователи взяли предобученную на протеиновых последовательностях BERT модель (TAPE). TAPE полностью повторяет по архитектуре BERT-Base: 12 слоев, каждый из которых содержит 12 механизмов внимания.