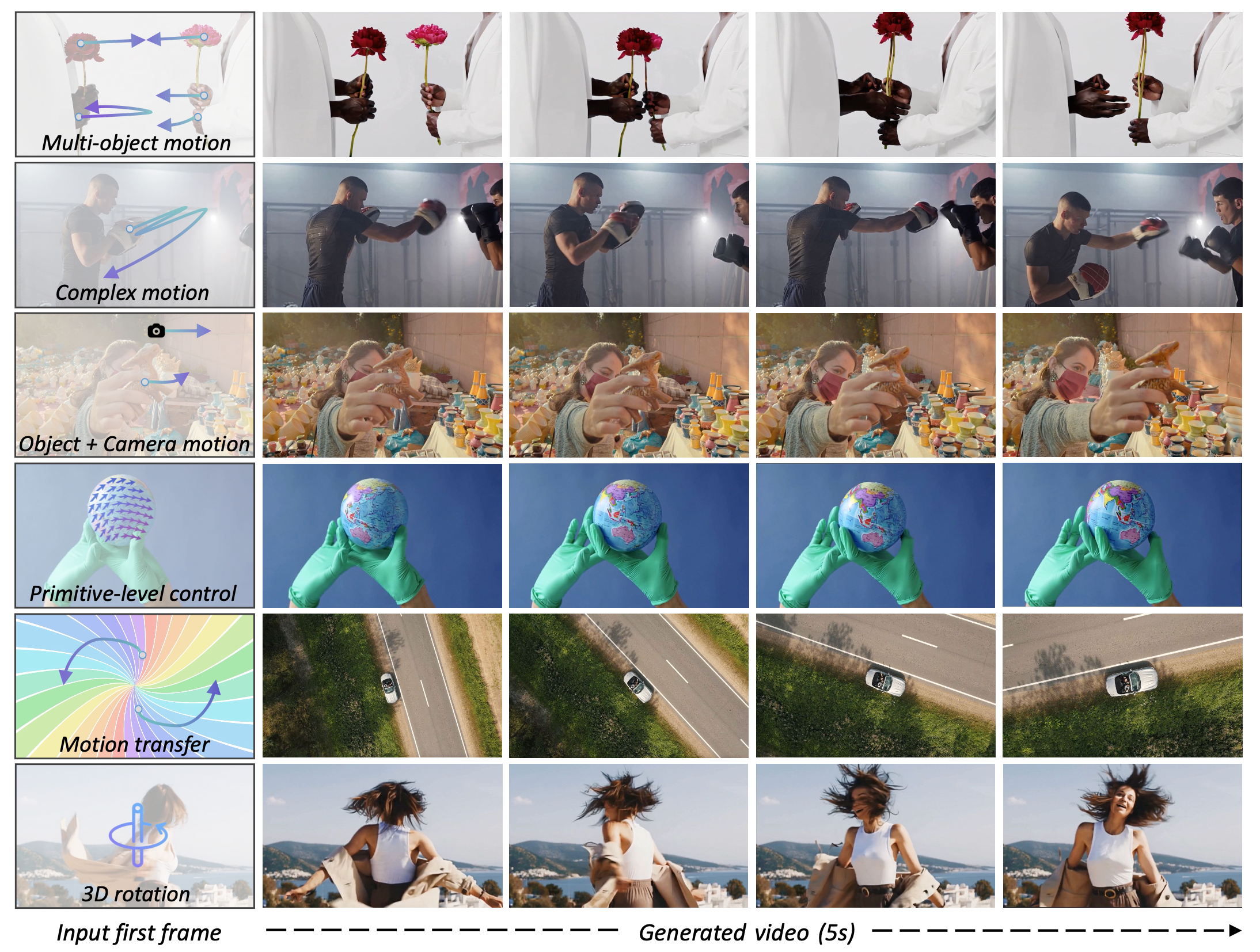

Команда исследователей из Tongyi Lab (Alibaba Group), Университета Цинхуа и Гонконгского университета представила Wan-Move — новый подход к точному контролю движения в генеративных видео-моделях. В отличие от существующих методов, которые требуют дополнительных энкодеров движения, Wan-Move напрямую редактирует признаки (condition features), встраивая информацию о движении без изменения архитектуры базовой модели. Метод генерирует 5-секундные видео разрешением 480p с точностью управления движением, сравнимой с коммерческим Motion Brush от Kling 1.5 Pro. Модель Wan-Move-14B-480P доступна для загрузки на Hugging Face, Github и ModelScope под отрытой лицензией Apache 2.0.

Как работает Wan-Move

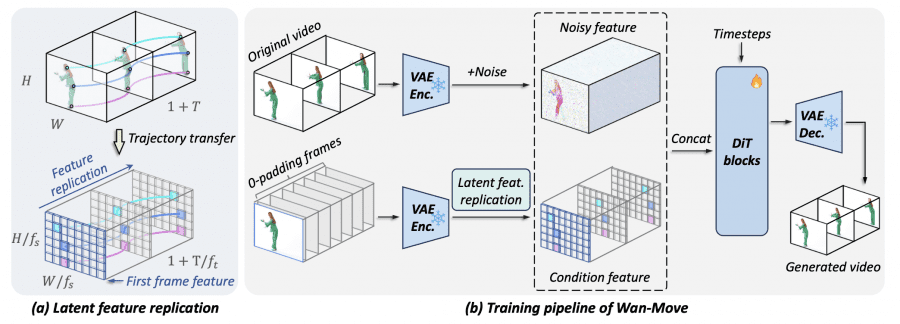

Wan-Move строится поверх существующей модели image-to-video Wan-I2V-14B без добавления вспомогательных модулей. Основная идея заключается во встраивании информации о движении путём прямого редактирования признаков условия первого кадра. Эти обновлённые признаки становятся латентным направляющим сигналом, который содержит информацию как о визуальном содержимом первого кадра (объекты, текстуры, цвета), так и о том, как эти объекты должны двигаться в последующих кадрах.

Движение представляется траекториями точек. В отличие от предыдущих работ, исследователи переносят каждую траекторию из пиксельного пространства в латентные координаты. Метод работает так: для каждой траектории движения модель берёт признак из стартовой точки на первом кадре и копирует его во все соответствующие позиции на последующих кадрах, следуя этой траектории. Каждый скопированный признак сохраняет богатый контекст, благодаря чему создаётся более естественное локальное движение.

MoveBench: новый бенчмарк

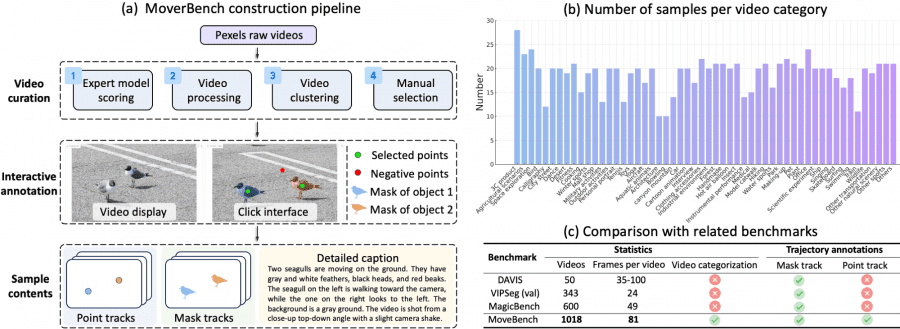

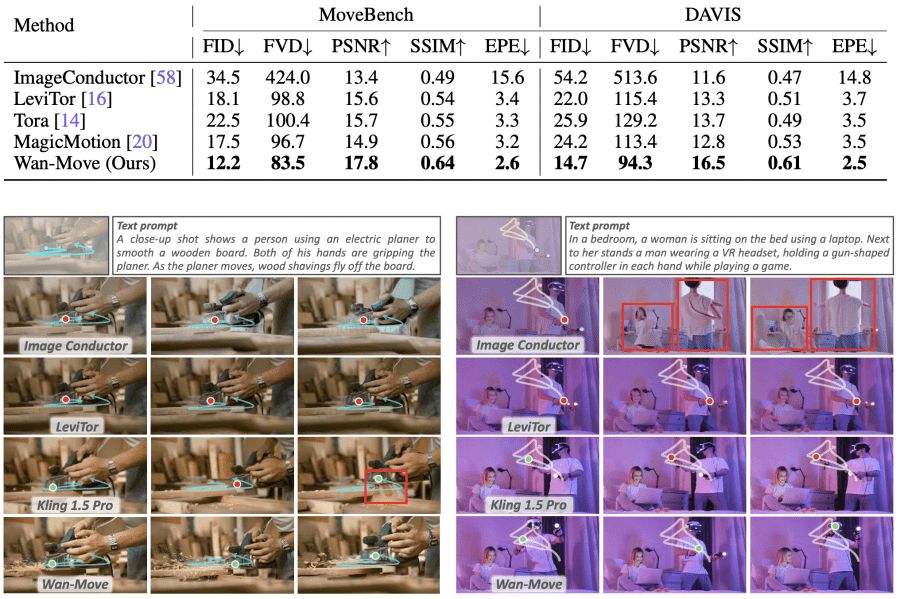

Исследователи создали MoveBench — новый бенчмарк из 1018 видео (разрешение 832×480, длительность 5 секунд) с детальной разметкой движения. Это позволяет проверить, насколько точно модели контролируют перемещение объектов на длительных временных интервалах и в разнообразных ситуациях.

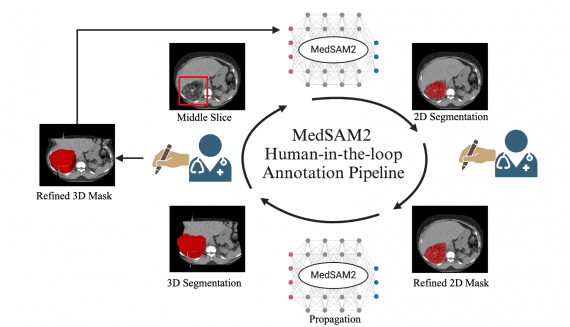

Видео проходят четырёхэтапный пайплайн подготовки: оценка качества с помощью экспертной модели, обработка с кадрированием до 480p и выборкой до 81 кадра, кластеризация в 54 категории контента и ручной отбор 15-25 репрезентативных примеров для каждой категории.

Для каждого видео предоставлены аннотации двух типов: точечные траектории и маски сегментации. Это позволяет тестировать методы с разными подходами к управлению. Разметка производилась с помощью интерактивного интерфейса: аннотаторы указывали целевую область в первом кадре, а SAM автоматически генерировал маску сегментации. В итоге каждое видео содержит минимум одну размеченную траекторию, а 192 видео включают движение нескольких объектов одновременно.

Результаты экспериментов

Wan-Move продемонстрировал лучшие результаты среди всех академических методов на бенчмарках MoveBench и DAVIS, значительно опередив конкурентов в сценариях с множественными объектами.

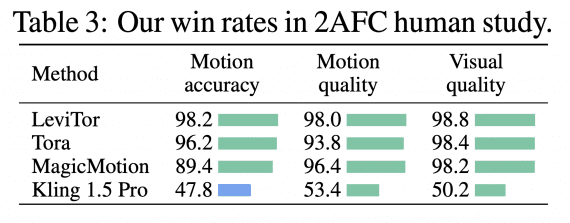

Для оценки относительно профессионального уровня провели пользовательское исследование методом 2AFC (выбор из двух вариантов), сравнивая Wan-Move с коммерческим Kling 1.5 Pro. Участники оценивали точность движения, качество движения и визуальное качество. Wan-Move показал конкурентоспособные результаты: выиграл по точности движения (52.2%) и качеству движения (53.4%), при сопоставимом визуальном качестве (50.2%). По сравнению с академическими методами Wan-Move получил процент побед выше 96% во всех категориях.

Абляционные исследования

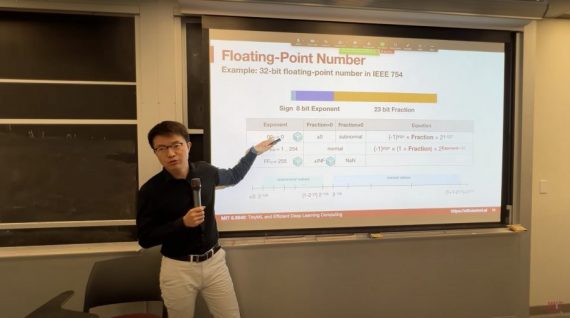

Сравнение ControlNet с прямой конкатенацией показало сопоставимую производительность (FID 12.2 против 12.4), но ControlNet увеличивает время вывода на 225 секунд, тогда как Wan-Move добавляет всего 3 секунды.

Оптимальная производительность достигается при 200 траекториях во время обучения. При выводе модель демонстрирует сильную способность к обобщению, достигая минимального EPE 1.1 при 1024 траекториях, хотя обучалась максимум на 200.

Выводы

Wan-Move представляет собой простой и масштабируемый фреймворк для точного контроля движения в генерации видео без архитектурных изменений базовой модели. Обширные эксперименты показывают, что метод генерирует высококачественные видео с управляемостью движения, сопоставимой с коммерческими инструментами. Проект распространяется под лицензией Apache 2.0, что позволяет свободно использовать модель для коммерческих и некоммерческих целей.