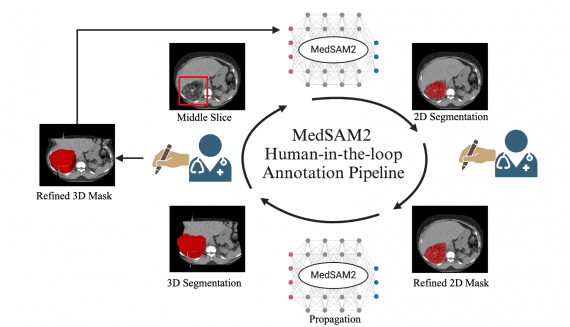

MedSAM2: открытая SOTA модель сегментации медицинских 3D-изображений и видео

13 апреля 2025

MedSAM2: открытая SOTA модель сегментации медицинских 3D-изображений и видео

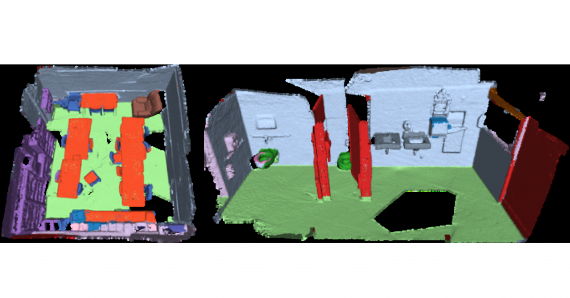

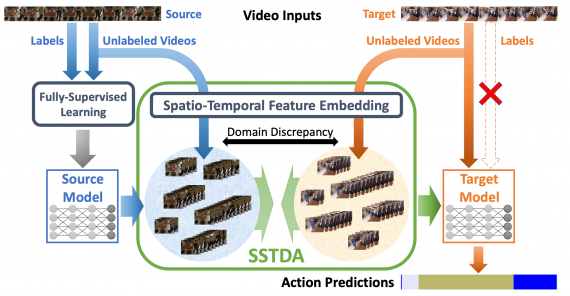

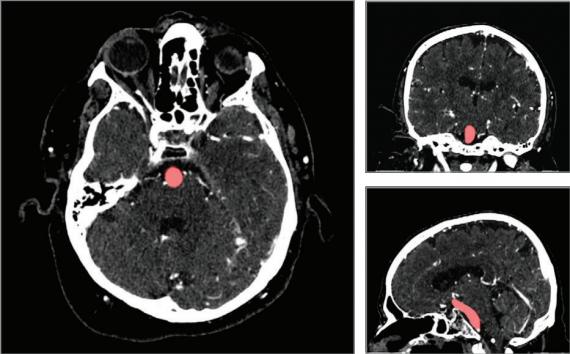

В последние годы был достигнут значительный прогресс в разработке как специализированных, так и универсальных моделей сегментации 2D медицинских изображений, однако область 3D и видеосегментации остается недостаточно исследованной. Группа исследователей из…