Dynabench — это платформа для динамического сбора данных и тестирования моделей. Для сбора данных платформа задействует ресурсы ручной и автоматической разметки одновременно. Dynabench разрабатывали в FAIR.

В Dynabench для оценки моделей машинного обучения используется новая процедура, — состязательный сбор данных. Метод измеряет, как просто обмануть модель человеку. Это является более стабильным индикатором качества модели, чем текущие методы оценки. Метрика лучше отражает поведение модели при взаимодействии с человеком, что является наиболее частым юзкейсом для ML-моделей.

На основе исторических данных использования Dynabench, платформа трекает, какие примеры данных обманывают модели и приводят к некорректным предсказаниям. Эти примеры становятся частью более сложных датасетов, на которых тренируются более устойчивые модели. Затем эти обновлённые модели становятся стандартом, для которых ищутся примеры данных, которые приводят к неверным предсказанием. Так, платформа позволяет итеративно улучшать качество моделей.

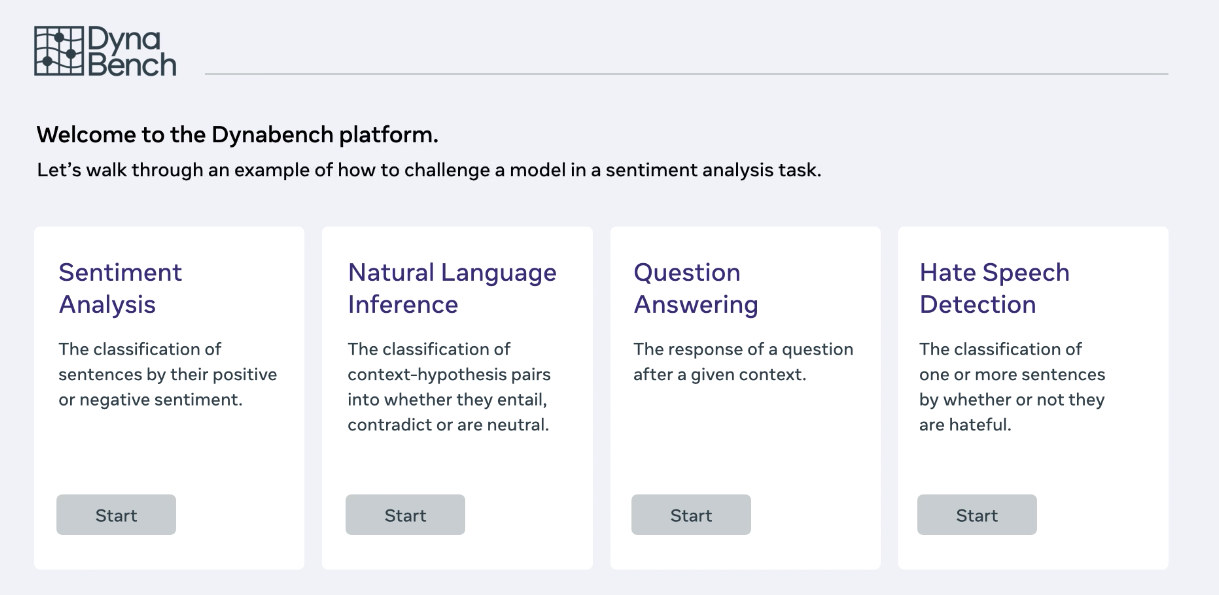

В основе Dynabench является научным экспериментом с целью выяснить, может ли сообщество разработчиков лучше оценивать возможности моделей и быстрее улучшать их качество. На данный момент платформа поддерживает оценку качества для моделей, которые решают 4 задачи в NLP:

- Анализ тональности текста;

- Задача логического вывода на естественном языке (natural language inference);

- Вопросно-ответная система;

- Распознавание ненавистнических высказываний

Подробнее узнать про систему можно на официальном сайте проекта.