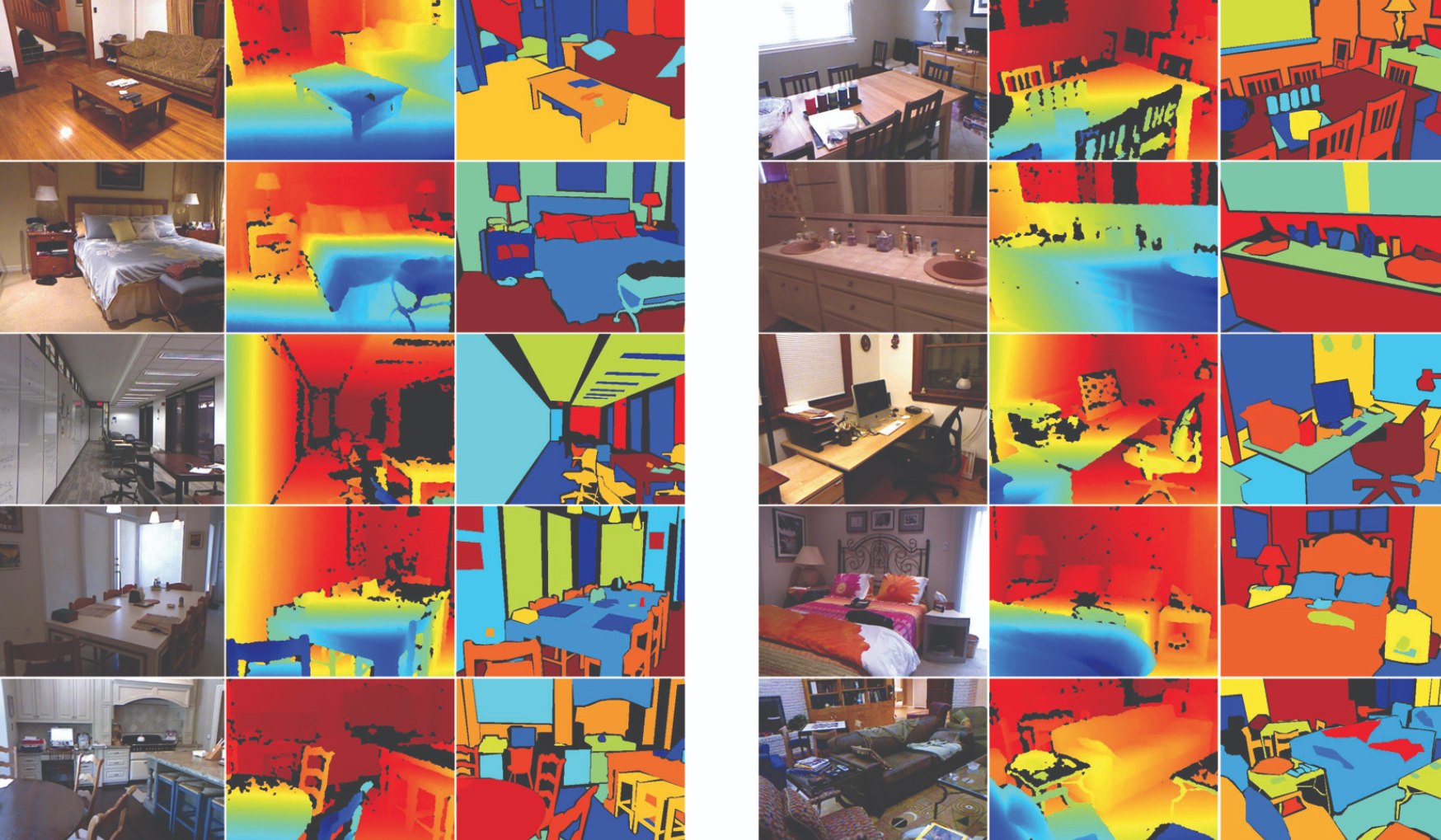

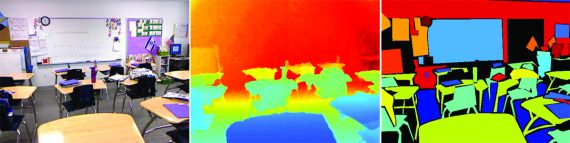

NYU Depth V2 — это датасет для сегментации объектов на изображениях интерьера. Датасет состоит из видеопоследовательностей из разных сцен интерьера, которые были записаны в RGB и с помощью камер глубины от Microsoft Kinect. Это обновленная версия NYU Depth датасета.

Подробнее про датасет

Данные содержат:

- 1449 размеченных пар изображен глубины и RGB изображений;

- 464 новые сцены, снятые в трех разных городах;

- 407,024 новых неразмеченных кадров

Каждый объект размечен классом и количеством инстансов (например, cup1, cup2, cup3 и т.д.).

Данные состоят из следующих компонентов:

- Размеченный набор данных: сабсет видеозаписей с размеченными лейблами объектов. Эти данные предобрабатывали таким образом, что бы заполнить отсутствующие лейблы классов;

- Сырой набор данных: сырые RGB изображения, изображения глубины и данные акселерометра, которые предоставляет Kinect

- Инструментарий: полезные функции для обработки данных и лейблов классов

Размеченные данные

Размеченный датасет — это сабсет сырого датасета. Он состоит из пар RGB изображений и изображений глубины, которые синхронизировали и разметили лейблами. Пропуски в изображениях глубины заполняли с помощью схемы колоризации от Levin et al.

Сырые данные

Сырой датасет содержит сырые изображения и данные акселерометра из Kinetic. RGB и камера глубины захватывали от 20 до 30 кадров в секунду. Несмотря на то, что кадры не синхронизированы напрямую, данные по таймстемпам хранятся в названии файлов. Их можно использовать для сборки всего видео с помощью функции get_synched_frames.m из Toolbox.