Методы нейронного поиска архитектуры (NAS) потенциально могут облегчить разработку архитектуры нейросетей. Однако существующие NAS алгоритмы обычно работают с ограниченным пространством поиска и ищут архитектуру на датасете, который схож с целевым. Исследователи предлагают Densely Connected NAS (DCNAS) фреймфорк, который позволяет более глубокий поиск архитектур. Кроме того, DCNAS позволяет избежать разницы между целевым датасетом и прокси-датасетом для поиска архитектуры.

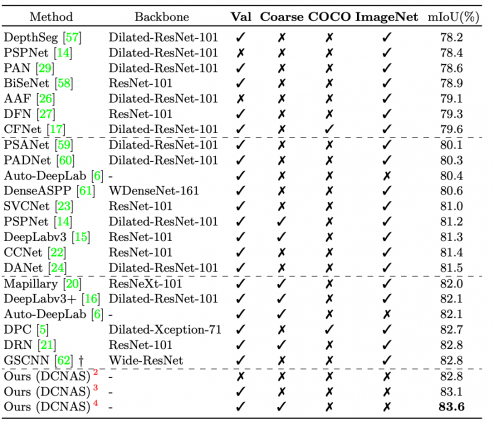

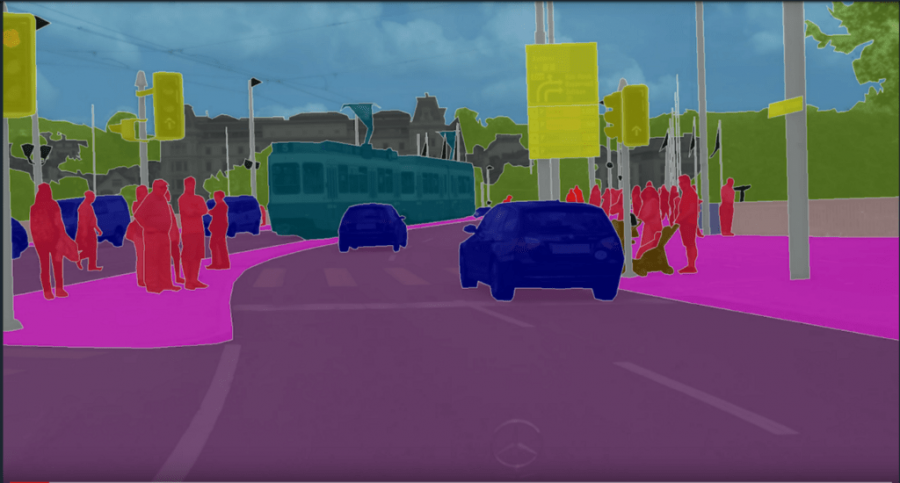

Модель напрямую ищет оптимальную структуру сети для представления изображений на целевом датасете. Архитектура из DCNAS выдает state-of-the-art результаты на задаче семантической сегментации. Модель тестировали на датасетах Cityscapes, PASCALVOC 2012, Pascal-Context и ADE20K.

DCNAS основывается на двух принципах:

- Пространство поиска должно быть достаточно понятным, чтобы уместить большинство популярных архитектур и ранее не использованные архитектуры;

- Отсутствие необходимости искать архитектуру на прокси-датасете меньшего размера, который отличается от целевого датасета

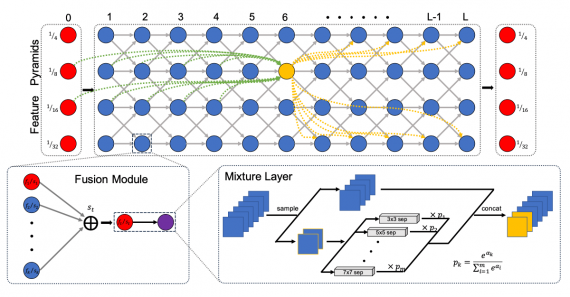

Первый принцип реализован в DCNAS с помощью сетчатой полносвязной структуры пространства поиска. Отдельные пути в пространстве отвечают за разные архитектуры. Чтобы решить вторую подзадачу, исследователи предлагают модуль объединения (fusion module), который позволяет сократить требования к памяти во время обучения. Например, для датасета Cityscapes поиск оптимальной архитектуры с помощью DCNAS занял 5.6 GPU дней.

Архитектура модели

Densely Connected Search Space (DCSS) — это сетчатое пространство поиска, которое нацелено на объединение семантических признаков. Чтобы выбрать структуру сети, достаточно отобрать связи в пространстве поиска и присвоить операции каждому слою.

Тестирование модели

Исследователи протестировали модель на датасетах Cityscapes, PASCALVOC 2012, Pascal-Context и ADE20K. На Cityscapes DCNAS обошла существующие state-of-the-art нейросети.