В Лас-Вегасе 3-7 августа проходила конференция по кибербезопасности Black Hat. На ней выявилась одна четкая тенденция — крупные компании готовы доверить защиту против хакерских атак искусственному интеллекту. Для этого есть две причины:

- квалифицированных кадров для работы над защитой от вредоностого ПО не хватает;

- количество кибератак ежегодно увеличивается, а модели по которым они проводятся усложняются.

Искусственный интеллект способен существенно разгрузить работников и помочь выявить потенциальные угрозы. Но зависимость от AI может стать дополнительным источником опасности.

Риск №1: Ложное чувство безопасности

Кажущаяся устойчивость ИИ к вредоносному ПО заставляет ослабить контроль за системами безопасности. Машинное обучение показывает отличные результаты во многих областях, и предприниматели ищут возможности применить его для обеспечения безопасности своего бизнеса. Они досконально не изучают возможные риски от передачи обязанностей программе, полностью полагаясь на поставщиков ИИ. Злоумышленники, как внедрясь в ряды сотрудников компании-разрабочика, так и удаленно, смогут «заражать» такое ПО.

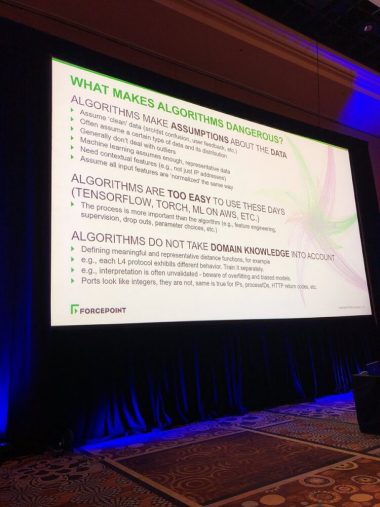

Риск №2: Датасеты, размеченные с ошибками

Для обучении ИИ необходим набор данных, который требует предварительной разметки (supervised learning). Из желания как можно скорее вывести продукт на рынок и сэкономить, компании начнут обучать свои ИИ на наборах, из которых не были до конца удалены аномальные данные. На выходе это приведет к непредсказуемым ошибкам в работе. Например, гражданская техника будет по ошибке размечена как военная, а в ходе конфликта ИИ примет решения об уничножении этого «военного объекта».

Риск №3: Уязвимости мастер-алгоритма

Если для управления системой безопасности используется один мастер-алгоритм, то при наличии уязвимости не будет инструментов, которые смогут указать на это. Если же использовать два или больше алгоритмов от независимых разработчиков, то они начнут конфликтовать между собой. К тому же при использовании крайне сложных моделей сложно понять по каким принципам они определяют одни ПО как вредоносные, а другие как «чистые».

Вывод

Использовать ИИ стоит с осторожностью, тщательно изучая принципы работы алгоритмов, применяя несколько программ, которые смогут указать на несовершенства. Риски необходимо минимизировать до ввода в работу ИИ и отслеживать их всегда по ходу работы.

По материалу MIT Technology Review.