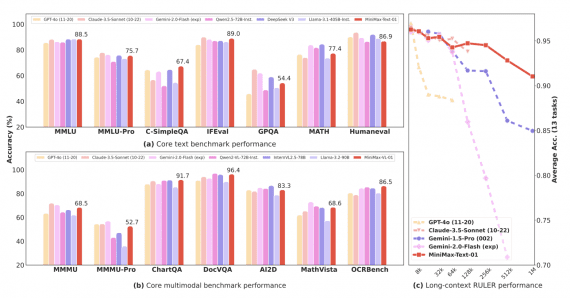

GLM-5: топ-1 открытая модель для генерации кода и текста, конкурирующая с Claude и GPT на агентных задачах

19 февраля 2026

GLM-5: топ-1 открытая модель для генерации кода и текста, конкурирующая с Claude и GPT на агентных задачах

Zhipu AI и Tsinghua University опубликовали техрепорт GLM-5 — на сегодня лучшей открытой языковой модели по бенчмаркам: первое место среди open-weight моделей на Artificial Analysis и топ-1 в кодинге и…