Visual-ARFT: новый метод обучения AI-агентов обходит GPT-4o в мультимодальных задачах

22 мая 2025

Visual-ARFT: новый метод обучения AI-агентов обходит GPT-4o в мультимодальных задачах

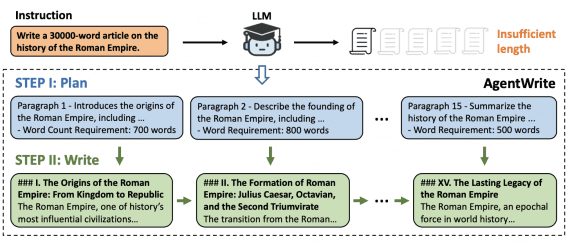

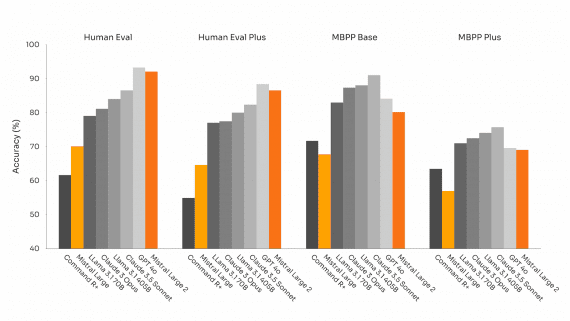

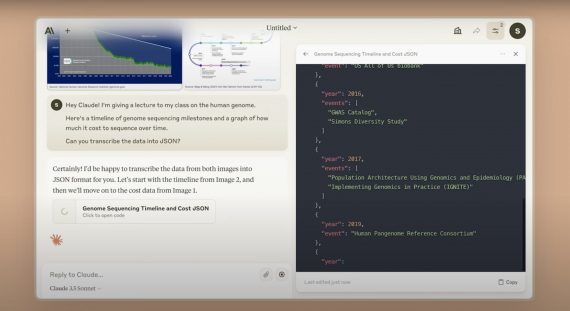

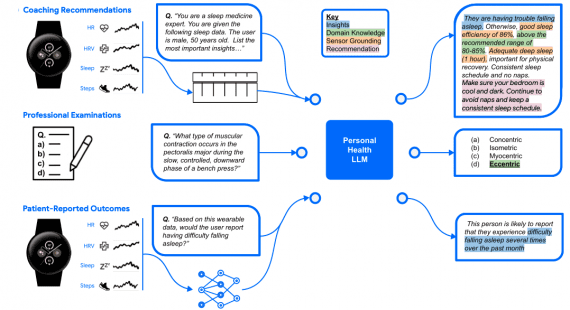

Исследовательская группа из Шанхайского университета Цзяо Тонг и Шанхайской лаборатории искусственного интеллекта представила Visual Agentic Reinforcement Fine-Tuning (Visual-ARFT) — новый подход к обучению крупных мультимодальных моделей агентным возможностям. Методика демонстрирует…