MiniCPM4: открытая локальная модель достигает производительности Qwen3-8B при 7-кратном ускорении инференса

15 июня 2025

MiniCPM4: открытая локальная модель достигает производительности Qwen3-8B при 7-кратном ускорении инференса

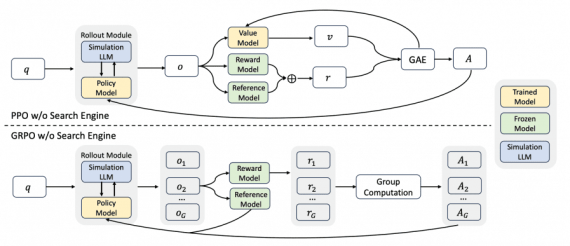

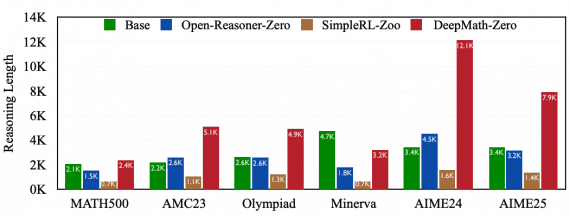

Команда исследователей OpenBMB представила MiniCPM4 — высокоэффективную языковую модель, разработанную специально для локальных устройств. MiniCPM4-8B достигает сопоставимой с Qwen3-8B производительности (81.13 против 80.55), при этом для обучения требуется в 4.5…