Камера для автономных поездов распознает объекты на расстоянии до 1 км

17 января 2019

Камера для автономных поездов распознает объекты на расстоянии до 1 км

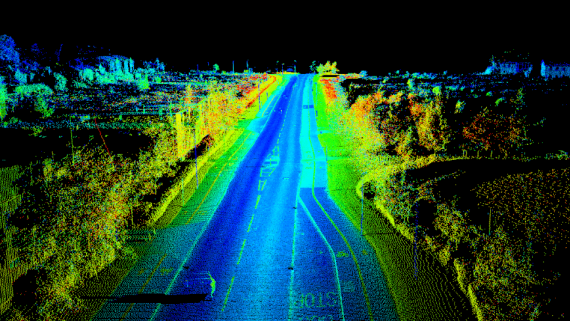

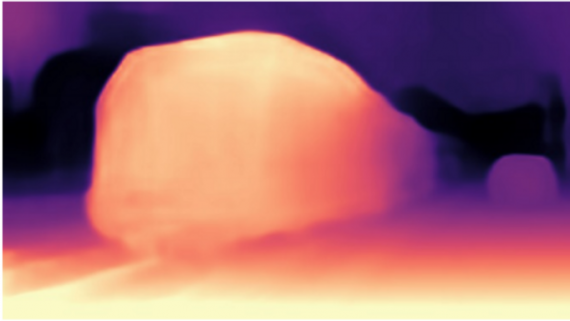

Разработчики Perceptin создали камеру для автономных поездов, которая распознает объекты и препятствия на расстоянии 1000 метров при скорости движения поезда до 300 км / час. Компания позиционирует разработку как универсальное…