В Hailuo AI появилась возможность генерировать видео на основе изображения

9 октября 2024

В Hailuo AI появилась возможность генерировать видео на основе изображения

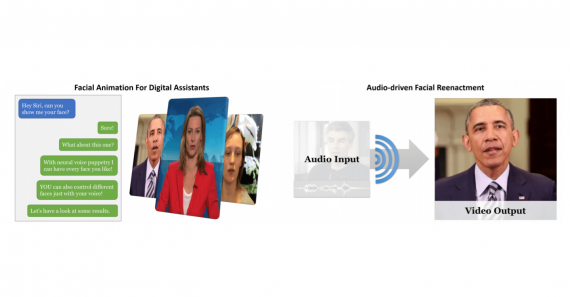

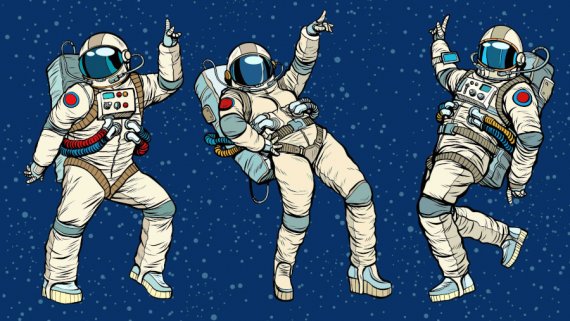

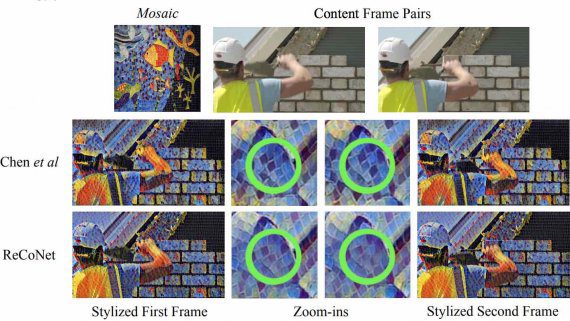

Платформа для генерации видео Hailuo AI запустила новую функцию Image-to-Video, позволяющую преобразовывать статичные изображения в динамичные видеоролики. После своего релиза в сентябре 2024 года Hailuo AI, созданная китайским стартапом MiniMax,…