Исследователи из Ubisoft предложили альтернативу Motion Matching алгоритму для автоматизированной анимации персонажей. Learned Motion Matching подход сочетает в себе преимущества классического Motion Learning алгоритма и нейросетей. Итоговая модель не хранит данные анимации или дополнительные метаданные в памяти, в отличие от стандартного MM алгоритма. При этом LMM модель сохраняет качество, контроль и быстрое время итерации, как в MM алгоритме.

Ограничения прошлого подхода

Несмотря на то, что нейросетевые генеративные модели для анимации персонажей способны выучивать компактные контроллеры, методы, как Motion Matching, все еще остаются наиболее популярными в игровой индустрии. Популярность обуславливается адаптивностью, качеством предсказаний, низким временем на предобработку и визуальным качеством. Однако затраты на память у таких подходов растет линейно с количеством используемых данных. Это приводит к необходимости балансирования между разнообразностью анимации и бюджетом на производство. Исследователи предлагают комбинировать нейросетевой подход и MM алгоритм. Это позволяет решить проблему с линейной масштабируемостью.

Как работает Learned Motion Matching алгоритм

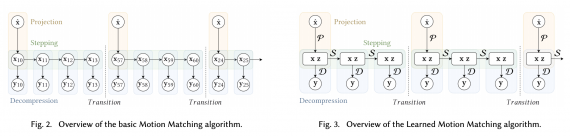

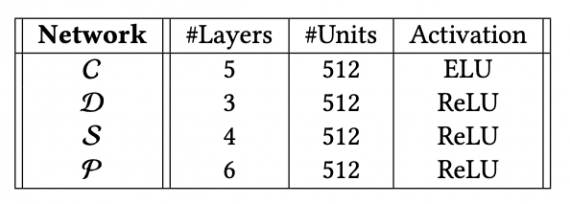

LMM алгоритм состоит из трех частей, как и стандартный MM алгоритм:

- Проекция;

- Декомпрессор;

- Переход к следующему шагу (stepping)

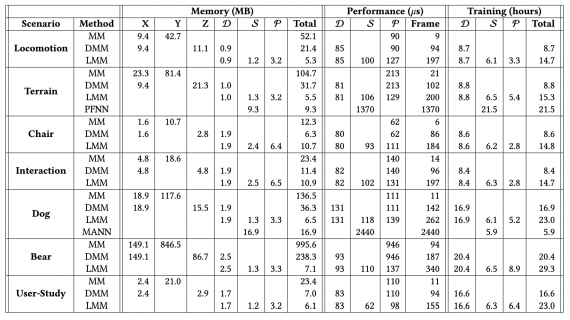

Оценка работы модели

Исследователи сравнили предложенный алгоритм с двумя базовыми алгоритмами: Motion Matching и Motion Matching with the Decompressor. Ниже видно, что Learned Motion Matching алгоритм затрачивает меньше памяти. При этом модель работает быстрее. Однако модель обучали на GPU, в то время как базовые алгоритмы обучались на CPU.