BigBiGAN — это генеративная нейросеть, которую адаптировали к задаче обучения представлений. В основе BigBiGAN лежит BigGAN, — текущий state-of-the-art для генерации изображений. Модель была разработана исследователями из DeepMind.

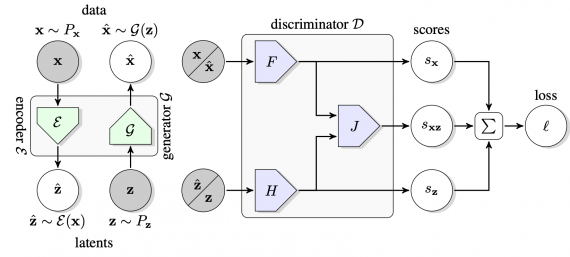

Состязательные генеративные модели (GANs) являются стандартными для задачи генерации изображений. Несмотря на ранний успех использования GAN для обучения представлений, их заменили self-supervised подходы. В своей работе используют последние наработки генеративных нейросетей в применении к задаче обучения представлений. BigBiGAN базируется на BiGAN и BigGAN. Фактически BigBiGAN — это BiGAN с генератором от BigGAN. Исследователи адаптировали модель к задаче обучения представлений через изменение дискриминатора и добавление кодировщика.

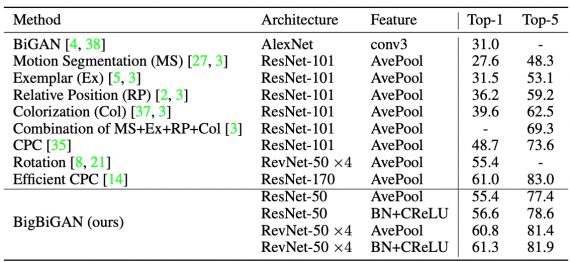

Результаты тестов показывают, что предложенная модель достигает state-of-the-art качества на данных ImageNet и в задаче обучения представлений, и в генерации изображений. Исследователи предлагают более стабильную версию дискриминатора в BigBiGAN. Целевая функция для обучения представлений помогает в задаче генерации изображений.

Что внутри BigBiGAN

Один из классов генеративных моделей, которые применялись для обучения представлений — это GAN. Генератор в GAN — это полносвязное отображение из случайно отбираемых латентных переменных (“шума”) в сгенерированные данные. Дискриминатор в GAN учится различать сгенерированные и реальные данные.

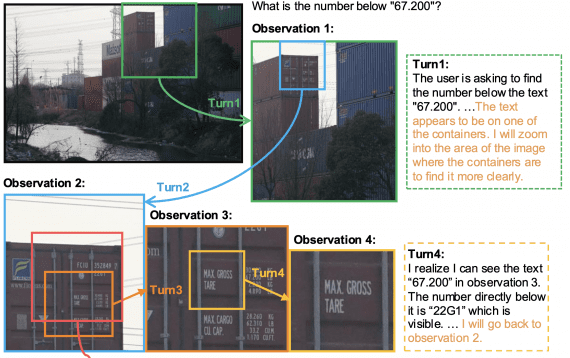

Двунаправленные GAN — это надстройка над GAN, которая уменьшает стандартный GAN с помощью отображения реальных данных в латентные (в шум). Это обратный процесс тому, что происходит в стандартном генераторе GAN. BiGAN может использоваться как представление свойств данных.

Структура BigBiGAN состоит из следующих компонентов:

- Общего дискриминатора, который используется для расчета функции потерь;

- Он принимает на входы пары единица данных и шум, которые отбираются из распределения реальных данных или сгенерированных данных и выходов кодировщика

Проверка работы модели

Сравнение BigBiGAN с конкурирующими подходами проходило на датасете ImageNet. Модели сравнивались на основании топ-1 и топ-5 точности. Подробное описание остальных экспериментов описано в оригинальной статье.