M2M-100 — это первая мультилингвальная модель машинного перевода, которая переводит на 100 языков и не задействует данные на английском языке при обучении. Разработчики опубликовали модель, пайплайн обучения и сетап оценки качества модели.

В чем отличие M2M-100

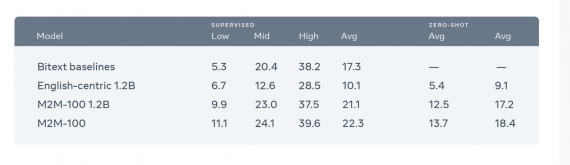

Предыдущие мультилингвальные модели обучались на данных переводов с английского и на английский язык, потому что данные на английском языке легкодоступны. M2M-100 учится напрямую переводить последовательность на входном языке на целевой язык. Например, с китайского на французский. В то время как предыдущие модели переводили с китайского на английский, а потом с английского на французский. Благодаря такому подходу M2M-100 обходит системы, основанные на английском языка, на 10 пунктов по BLEU метрике.

Подробнее про модель

M2M-100 обучали переводить на 2,200 языковых направлений. Это в 10 раз больше, чем прошлая лучшая мультилингвальная модель машинного перевода. Модель обучалась на 7.5 миллиардах параллельных предложений 2,200 языковых направлений.