mT5 — предобученный мультилингвальный Transformer для 101 языков. mT5 является расширением модели Text-to-Text Transfer Transformer (T5). Архитектуру T5 разработали исследователи из Google AI. mT5 обучался на корпусе веб-страниц из Common Crawl на 101 языках, — mC4. Исследователи опубликовали чекпоинты модели и обучающие данные в репозитории на GitHub.

Подробнее про модель

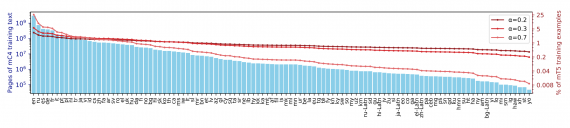

Архитектура модели и процедура обучения mT5 схожа с архитектурой и обучением классической T5 модели. mT5 основывается на версии “T5.1.1” модели T5, в которой используют GeGLU нелинейность и предобучают на неразмеченных данных без использования dropout. Данные на разных языках семплировали так, что бы можно было регулировать баланс между редкими и популярными языками веб-страниц. Для этого вычисляли вероятность семплинга текста на определенном языке.

Тестирование работы модели

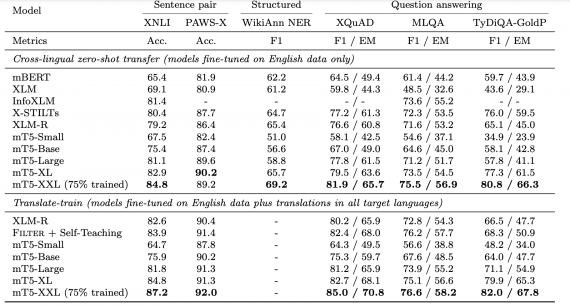

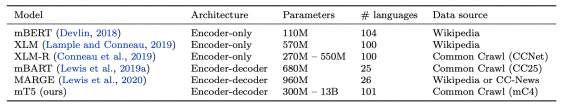

Работу mT5 сравнивали с state-of-the-art мультилингвальными Transformer-моделями на задачах классификации пары предложений, структурного предсказания и вопросно-ответной системы. Для тестов использовали бенчмарк xtreme. Ниже видно, что предложенная mT5 обходит существующие подходы на всех задачах и по всех метрикам.