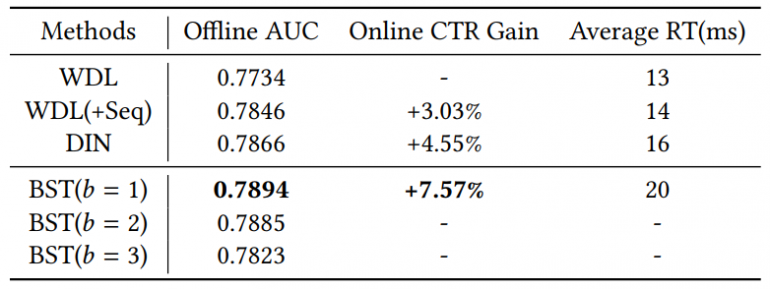

Исследователи из Alibaba Group опубликовали описание модели Behavior Sequence Transformer (BST), которая применяется в рекомендательной системе сайта Taobao. Особенность модели заключается в том, что она анализирует последовательности действий, совершенных пользователями. Это позволило значительно увеличить показатель кликабельности (click-through rate, CTR) по сравнению с двумя базовыми показателями — WDL и DIN.

Принцип работы

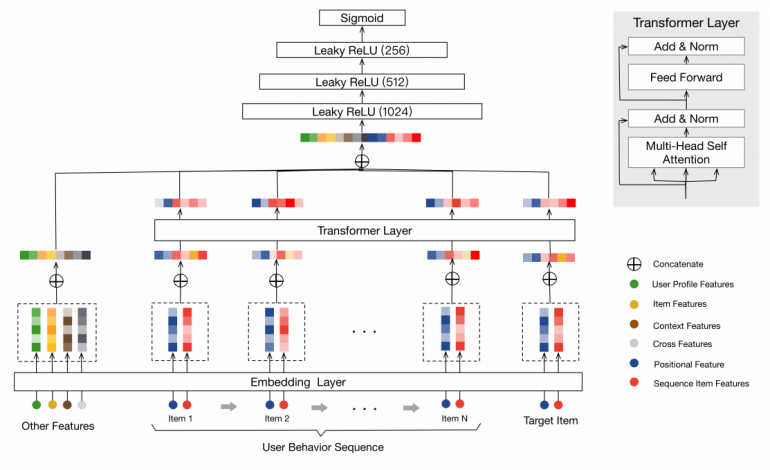

BST принимает в качестве входных данных последовательность поведения пользователя, включая целевой элемент и “другие признаки”. Сначала он формирует из этих входных признаков эмбеддинги (векторные представления). Чтобы лучше фиксировать отношения между элементами в последовательности поведения, слой Transformer используется для изучения более глубокого представления для каждого элемента в последовательности. Этот слой включает в себя self-attention слой с последующей нормализацией, а также поточечный слой прямого распространения (point-wise feed forward) с последующей нормализацией.

Self-attention слой включает в себя вычисление внимания к точечному объекту, что выражается как:

где Q — запросы, K — ключи и V — значения, d — размерность признаков.

После self-attention слоя путем конкатенации эмбеддинга «других признаков» и выхода слоя Transformer, три полносвязных слоя используются для обучения взаимодействий скрытых признаков, а функция сигмоид используется для генерации конечного результата в виде вероятности от 0 до 1.

Результаты

С помощью self-attention, BST обеспечивает мощную возможность захвата последовательного сигнала, лежащего в основе последовательностей поведения пользователей. Из опыта Alibaba, даже небольшой прирост оффлайн AUC приводит к огромному выигрышу в онлайн CTR.