Mistral Agents API: фреймворк для создания AI-агентов с веб-поиском, генерирующих код и изображения

28 мая 2025

Mistral Agents API: фреймворк для создания AI-агентов с веб-поиском, генерирующих код и изображения

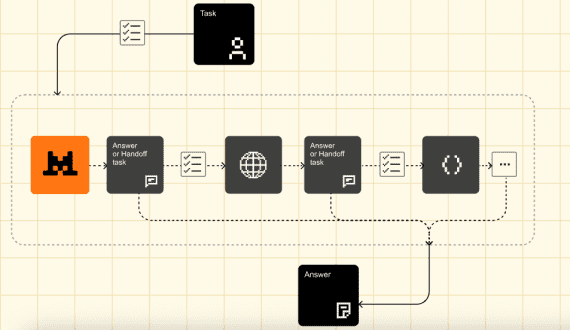

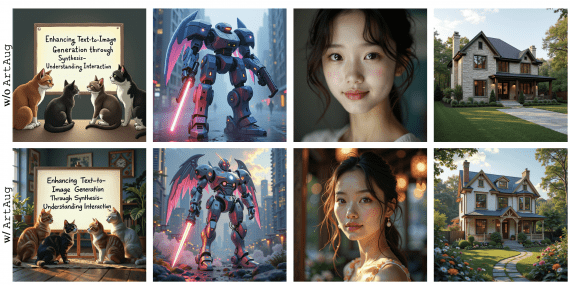

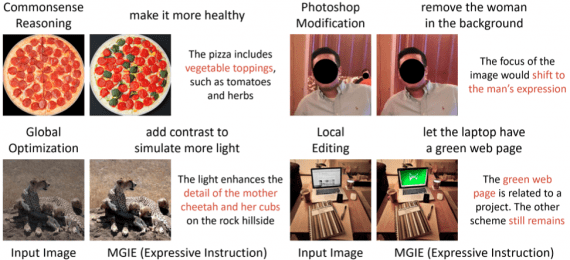

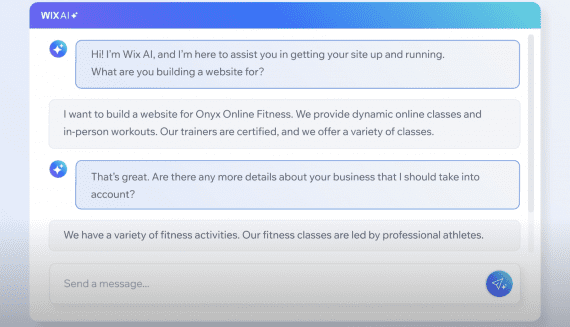

Французский стартап Mistral AI представил Agents API — фреймворк для создания автономных AI-агентов со встроенными коннекторами, постоянной памятью и возможностями оркестрации. Разработчики могут создавать неограниченнное число агентов и выстраивать пайплайны…