CowMask — это метод аугментации, который основан на маскировании. Метод позволяет обучать более устойчивые self-supervised модели. Модель с CowMask выдает state-of-the-art результаты на датасете ImageNet с использованием 10% размеченных данных при обучении. При этом топ-5 процент ошибок у модели — 8.76%, а топ-1 — 26.06%. Использование CowMask позволяет обучать модели с state-of-the-art качеством и более простой архитектурой. Исследователи протестировали CowMask для semi-supervised обучения на датасетах SVHN, CIFAR-10 и CIFAR-100. Модели с предложенным подходом выдавали результаты, сравнимые с state-of-the-art. Код проекта доступен в открытом репозитории на GitHub.

Консистентность в semi-supervised обучении

Регуляризация консистентности — это метод для semi-supervised обучения, который позволяет тренировать модель с использованием небольшого количества размеченных данных. Он работает таким образом, что модель обучается устойчивости к изменениям в неразмеченных данных.

Как работает CowMask

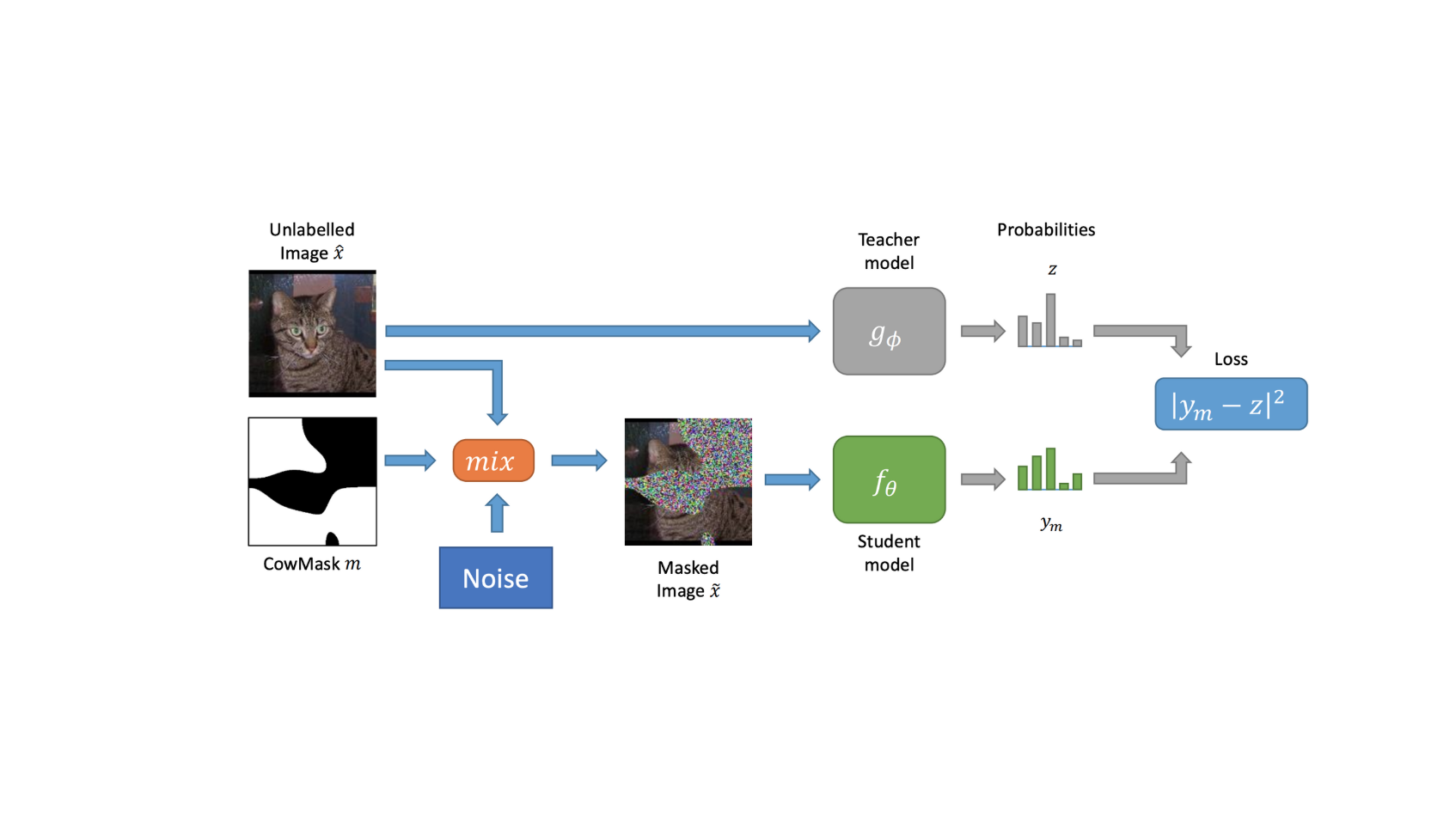

Исследователи адаптировали фреймворк Mean Teacher и использовали его в качестве базы для подхода. Они использовали две сети: сеть-студент и сеть-учитель. Обе модели предсказывают векторы с вероятностями для каждого класса. Сеть-студент обучается стандартно с использованием градиентного спуска. После каждого обновления параметров веса сети-учителя обновляются так, что они являются экспоненциальным скользящим средним от весов модели-студента. При этом есть гиперпараметр, с помощью которого регулируются стабильность и скорость того, как сеть-учитель следует за сетью-студентом.

Псевдокод алгоритма генерации CowMask

CowMask использовали для двух типов регуляризации консистентности: маскированное стирание (mask-based erasure) и маскированное смешение (mask-based mixing).

Псевдокод с функционалами для двух типов регуляризации: стирание и смешение

Подробности оценки подхода доступны в оригинальной статье.