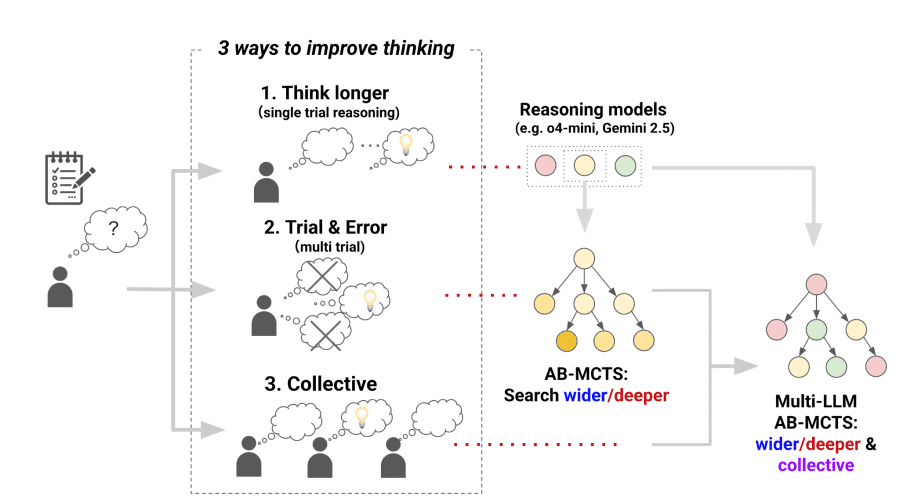

Исследователи из Sakana AI представили Adaptive Branching Monte Carlo Tree Search (AB-MCTS) — революционный подход к созданию «команд мечты» из больших языковых моделей, который позволяет им динамически сотрудничать для решения сложных задач. Метод обеспечивает превосходство в 30% над отдельными моделями на сложнейшем бенчмарке ARC-AGI-2. Метод реализован в открытом фреймворке TreeQuest, доступном для коммерческого использования.

Концепция коллективного интеллекта

Каждая LLM имеет уникальные сильные и слабые стороны. Одна модель может превосходить в программировании, другая — в творческом письме. Исследователи Sakana AI рассматривают эти различия как ценные ресурсы для создания коллективного интеллекта. Подобно человеческим командам, AI-модели достигают большего через сотрудничество.

Проблемы традиционных подходов

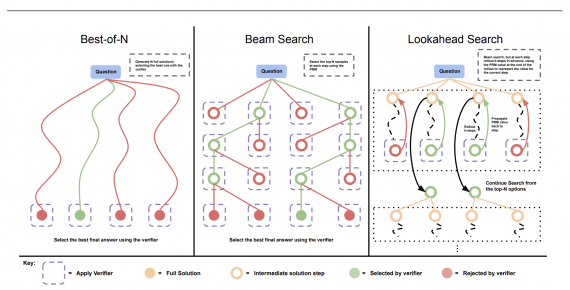

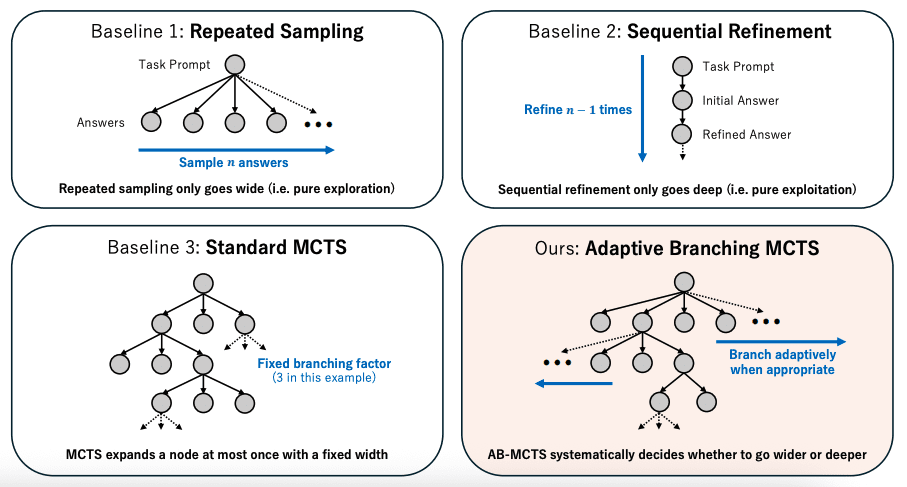

Repeated sampling генерирует множественные кандидаты из одного промпта, но фокусируется исключительно на исследовании без эксплуатации обратной связи.

Стандартный MCTS использует фиксированный коэффициент ветвления, ограничивая масштабирование.

Отдельные модели не могут эффективно объединять различные экспертные знания.

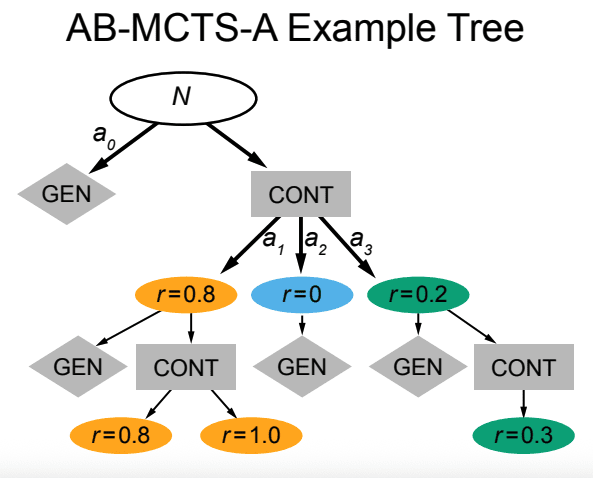

Архитектура AB-MCTS

AB-MCTS решает проблему внедрения неограниченного ветвления в древовидный поиск, не фиксируя ширину как статический гиперпараметр.

Механизм GEN-узлов

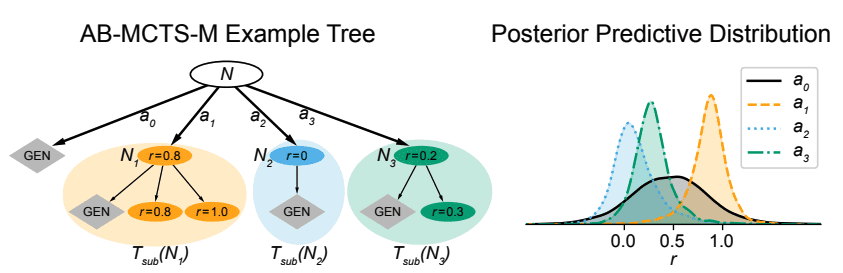

Для представления действия генерации новых дочерних узлов AB-MCTS применяет GEN-узлы. Каждый узел N имеет GEN-узел в качестве дочернего. При выборе GEN-узла система расширяет родительский узел, добавляя нового потомка.

Два варианта реализации

AB-MCTS-M (Mixed Model) использует байесовскую смешанную модель для моделирования распределений оценок. Система назначает каждому поддереву под узлом Nj отдельную группу, используя общие параметры для захвата характеристик качества ответов.

AB-MCTS-A (Node Aggregation) агрегирует все дочерние узлы под единым CONT-узлом, представляющим уточнения существующих решений.

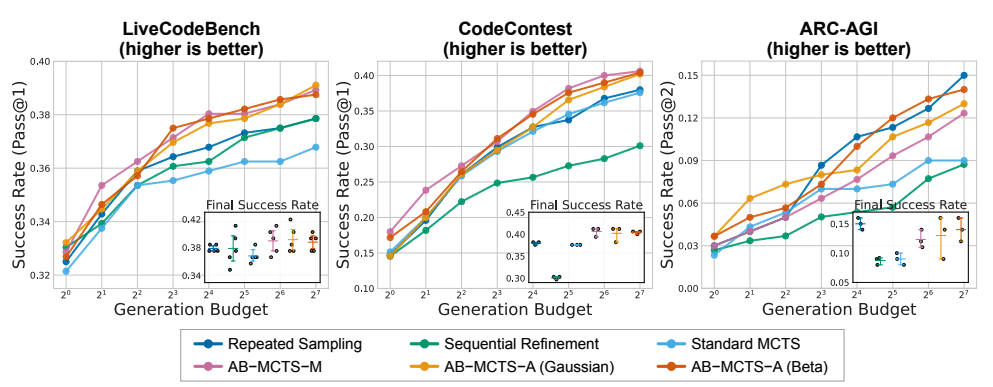

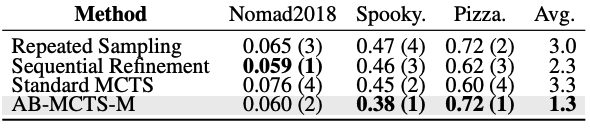

Экспериментальные результаты

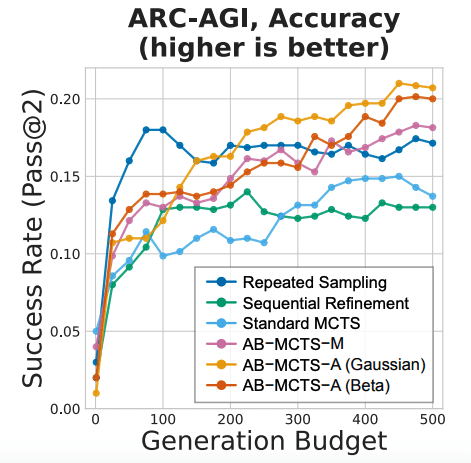

AB-MCTS протестирован на четырех бенчмарках: LiveCodeBench, CodeContest, ARC-AGI и MLE-Bench, используя GPT-4o и DeepSeek-V3 с бюджетом 128 вызовов.

Результаты

На LiveCodeBench AB-MCTS достигает 39.1% против 37.8% у repeated sampling. На CodeContest — 40.6% против 37.9%. На ARC-AGI показывает 15.0% успешности. На MLE-Bench демонстрирует лучший средний ранг среди всех методов.

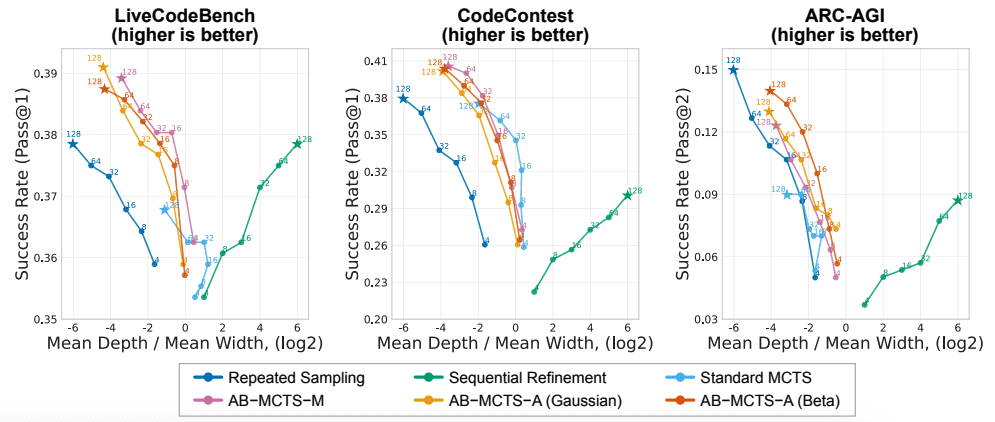

Анализ поведения поиска

AB-MCTS генерирует более широкие деревья по сравнению со стандартным MCTS благодаря способности адаптивно принимать решения о расширении поиска.

При увеличении бюджета до 512 вызовов AB-MCTS продолжает улучшаться, в то время как repeated sampling достигает плато.

Multi-LLM: создание команд AI

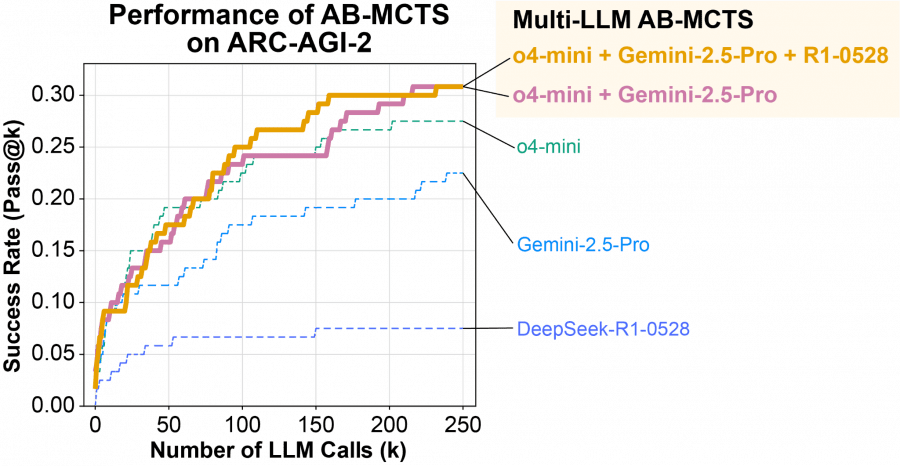

Multi-LLM AB-MCTS решает не только «что делать», но и «какая модель должна это делать». Метод начинает с балансированного использования LLM и изучает эффективность каждой модели, перераспределяя нагрузку к наиболее результативным.

Принцип работы Multi-LLM

В начале задачи система не знает, какая модель лучше подходит для конкретной проблемы. Она начинает с сбалансированного использования доступных LLM и по мере прогресса изучает эффективность каждой модели, перераспределяя нагрузку к наиболее результативным.

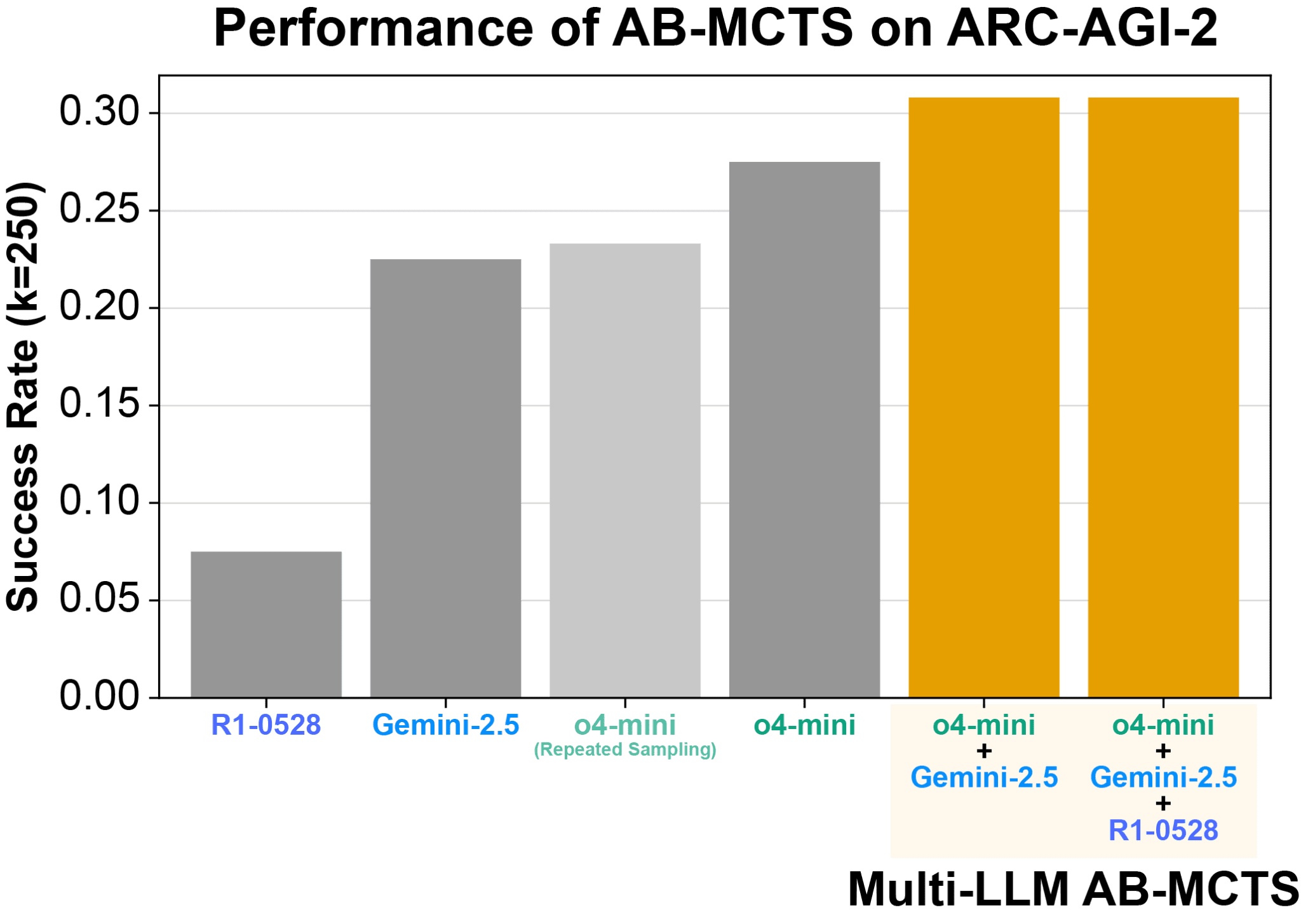

Прорывные результаты на ARC-AGI-2

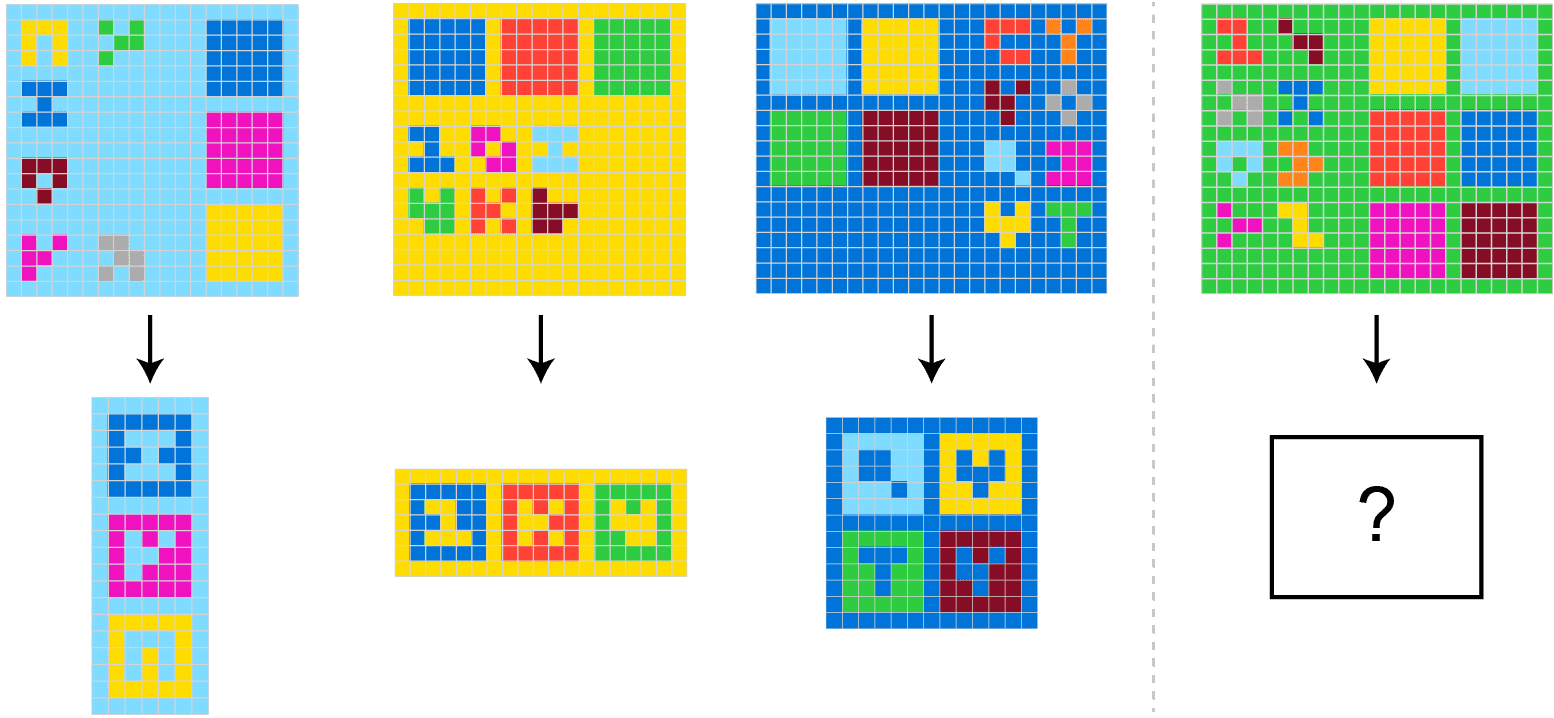

Метод был протестирован на ARC-AGI-2 — одном из самых сложных бенчмарков для AI, требующем человекоподобного визуального мышления. Команда использовала три frontier-модели:

- o4-mini

- Gemini 2.5 Pro

- DeepSeek-R1-0528

Коллектив моделей смог найти правильные решения для более чем 30% из 120 тестовых задач — результат, значительно превосходящий любую отдельную модель.

Синергетическое сотрудничество

Наиболее впечатляющим оказалось решение «нерешаемых» задач — проблем, с которыми не справлялась ни одна отдельная модель. В одном случае неправильное решение o4-mini послужило подсказкой для DeepSeek-R1-0528 и Gemini-2.5 Pro, которые проанализировали ошибку, исправили её и получили верный ответ.

TreeQuest: от исследований к практике

Sakana AI выпустила открытый фреймворк TreeQuest под лицензией Apache 2.0 для коммерческого использования. TreeQuest предоставляет API для реализации Multi-LLM AB-MCTS.

Практические применения

TreeQuest открывает возможности для решения реальных бизнес-задач:

- Итеративная оптимизация: автоматический поиск способов улучшения метрик производительности существующего ПО

- Снижение времени отклика веб-сервисов через интеллектуальную оптимизацию

- Улучшение точности моделей машинного обучения

- Комплексное алгоритмическое программирование

Борьба с галлюцинациями

Multi-LLM снижает галлюцинации через ансамбли моделей с различной склонностью к ошибкам — критично для бизнес-применений.

Ограничения и будущие направления

Подход требует наличия надежного оценщика качества решений, что может быть вызовом в зависимости от задачи. Будущие исследования могут сосредоточиться на включении более детализированных факторов стоимости реального мира помимо количества вызовов API.

AB-MCTS открывает перспективы эффективного масштабирования инференса через адаптивную стратегию поиска, демонстрируя превосходство над существующими методами на разнообразных сложных задачах.