TensorFlow представили библиотеку для тестирования приватности. TensorFlow Privacy — это модуль, который позволяет разработчикам оценивать приватность обученных классификаторов.

Приватность является актуальным фокусом в сообществе ML-разработчиков. На данный момент не существует стандартов по обучению приватных моделей. Уже существуют кейсы, когда ML-модель провоцировала утечку конфиденциальной информации об обучающем датасете. Это создает риски для пользователей из набора данных для обучения модели.

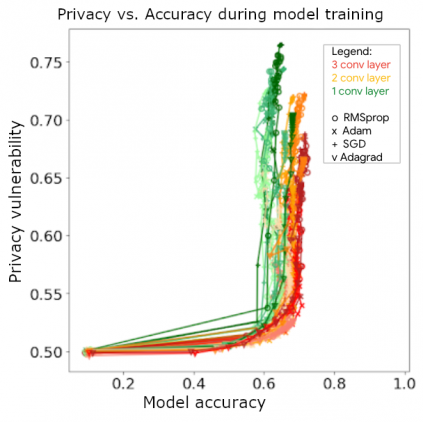

Первая версия TensorFlow Privacy позволяла разработчикам возможность обучать свои модели с дифференциальной приватностью. Дифференциальная приватность добавляет шум к данным, чтобы скрыть отдельные примеры из обучающего датасета. Однако такой шум может влиять на точность модели.

Проверка моделей на уязвимость

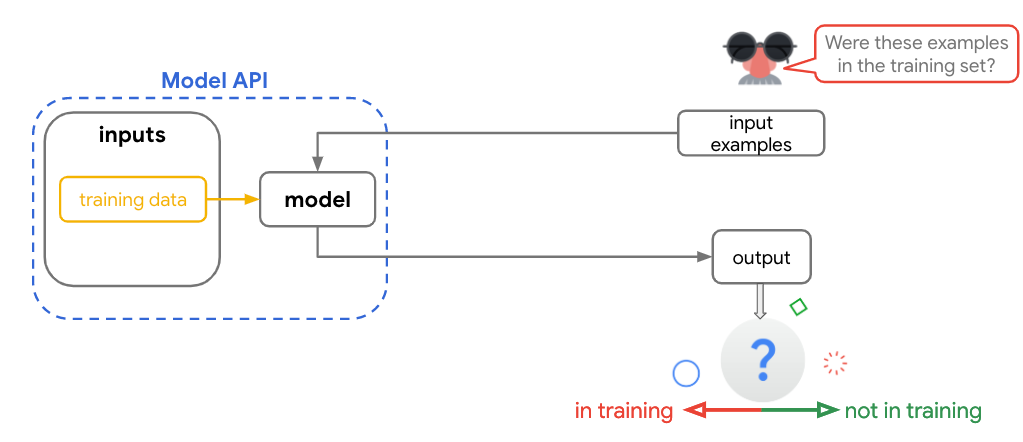

Membership inference атаки предсказывают, использовался ли определенный кусок данных при обучении модели. Если атакующий способен верно предсказывать это с высокой точностью, это говорит о высокой степени уязвимости модели. Основное преимущество таких атак в простоте использования. Они не требует заново обучать модель.

В новом релизе разработчики добавили функционал тестирования моделей на степень уязвимости. Тест выдает оценку уязвимости, которая показывает, есть ли в модели утечка информации об обучающем наборе данных. Использование методов дифференциальной приватности снижает уязвимость модели, даже при маленьком количестве шума.

Цель библиотеки заключается в том, что бы спровоцировать исследования в области безопасного обучения ML-моделей.