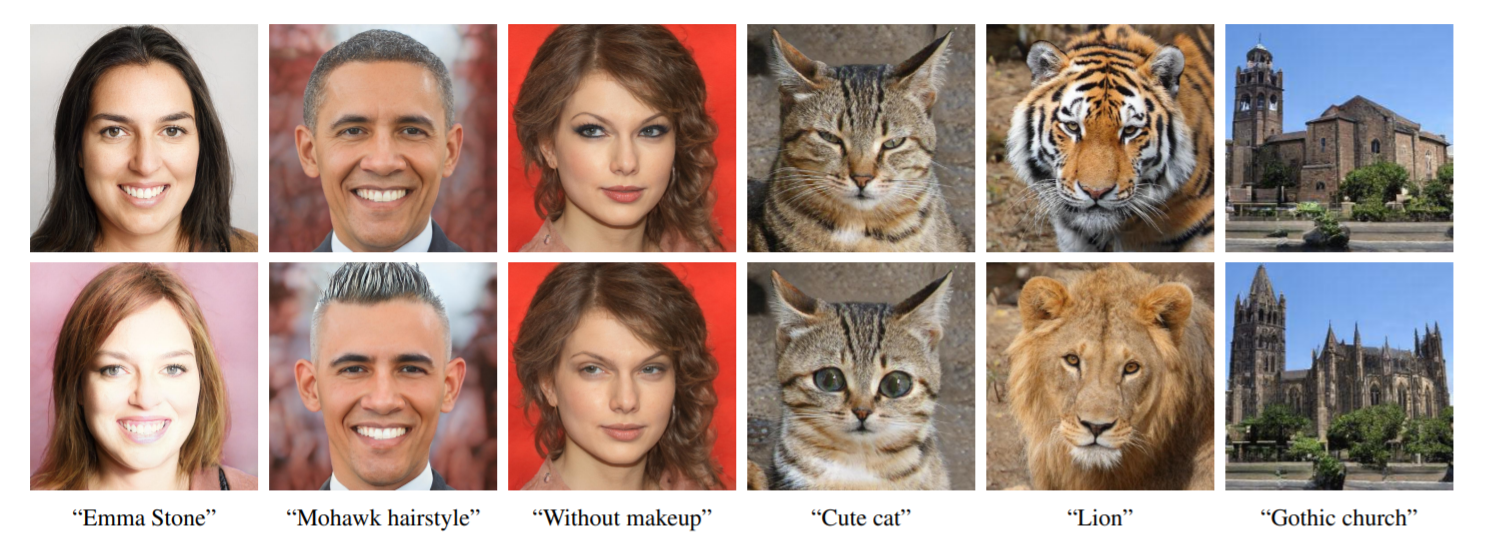

StyleCLIP — это связка моделей CLIP и StyleGAN, предназначенная для управления стилем изображений при помощи текстового описания. Код в открытом доступе, включая блокноты Google Colab.

Зачем это нужно

Модели StyleGAN способны генерировать очень реалистичные изображения, например, портреты никогда не существоваших людей. Несмотря на их широкое использование, они работают по принципу чёрного ящика. Это значит, что для управления выходным результатом необходимы изображения-примеры. Иначе требуется кропотливое исследование многомерного пространства свойств, спрятанного под капотом модели.

Попытки создать текстовый интерфейс для управления StyleGAN не новы. Однако существующие интерфейсы позволяют изменять только заранее заданные свойства изображений. Авторы применяют CLIP для задания стиля изображений произвольным, интуитивным текстовым описанием.

Как это работает

Особенность нейронной сети CLIP — это возможность узнавать содержимое изображения среди подписей на естественном языке. Модель CLIP, использованная в работе, предварительно обучена на 400 миллионах пар изображение-текст. Поскольку естественный язык способен выражать широкий набор визуальных концепций, объединение CLIP с мощностью генерации StyleGAN открывает простор для управления стилями изображений.

Исследованы три метода, сочетающих CLIP со StyleGAN:

- Оптимизация скрытого пространства при помощи текстовых подсказок, где модель CLIP используется в качестве сети потерь. Это наиболее универсальный подход, но он требует нескольких минут оптимизации, чтобы применить коррекцию к изображению.

- Остаточный разметчик скрытого пространства, обученный для конкретной текстовой подсказки. Учитывая входное изображение как начальную точку в скрытом пространстве, модель выдает локальный шаг для коррекции изображения.

- Метод отображения текстовой подсказки в независимое от ввода (глобальное) направление в пространстве стилей StyleGAN. Обеспечивает контроль над силой коррекции и степенью распутывания.

сделай из этого фото реального человека