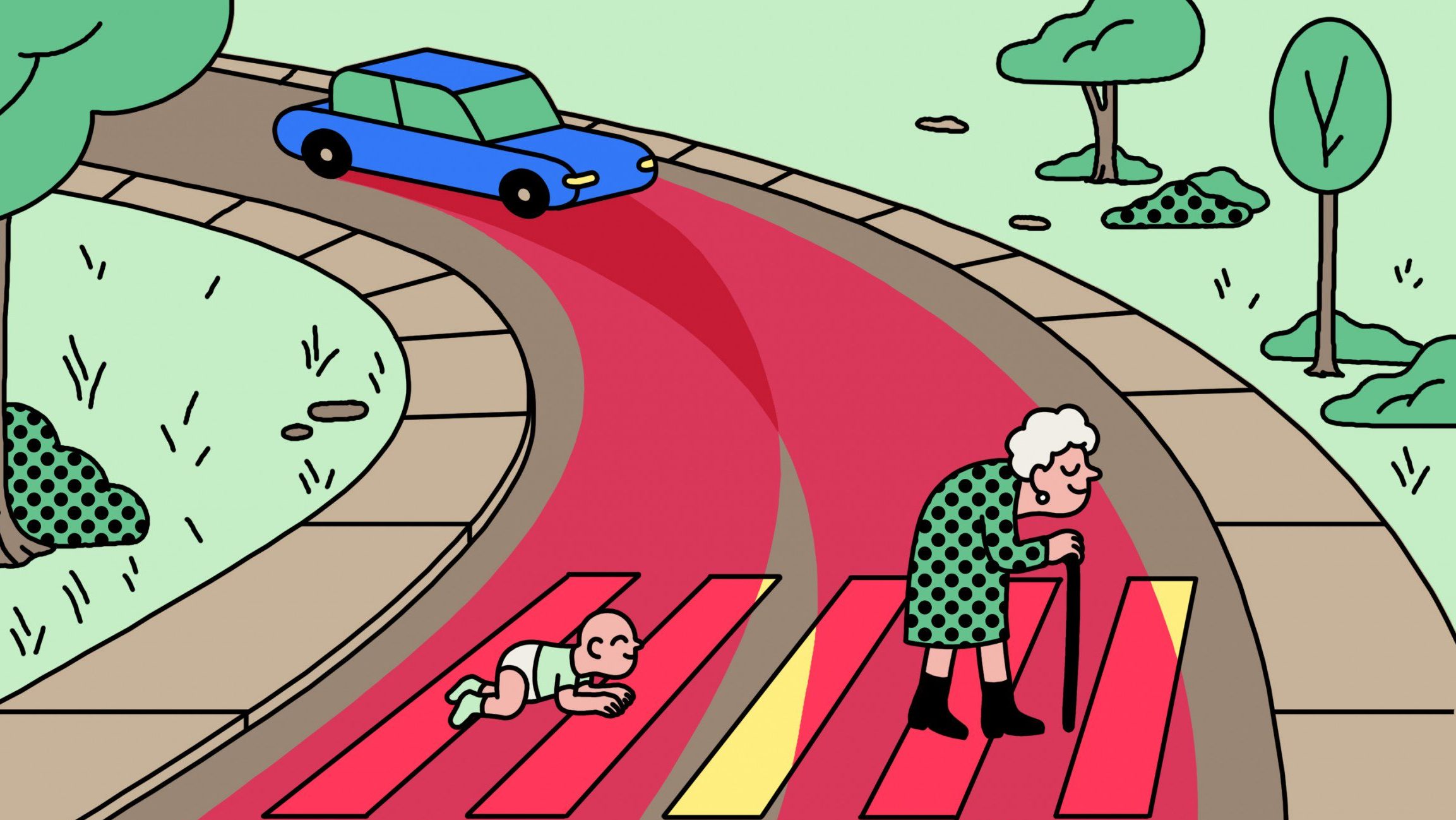

Алгоритмы должны уметь принимать сложные этические решения. ИИ, который помогает судьям выносить приговоры, должен учитывать риски как для общества, так и для обвиняемого. Автомобили без водителя должны принимать решения в случае неизбежного столкновения с двумя пешеходами, а автономному оружию придется анализировать относительную ценность жизни солдат и мирных жителей.

Подобные дилеммы неразрешимы не только для алгоритмов, но и для людей. Этики изучали их десятилетиями и называют их теоремами невозможности.

Питер Эккерсли — директор Partnership on AI & EFF — выпустил статью, которая исследует принятие этических решений в контексте искусственного интеллекта. Для того, чтобы нейронная сеть могла работать с несколькими конкурирующими целями, ученый предлагает встроить неопределенность в сами алгоритмы.

Для реализации подхода предлагается использовать частичное упорядочение (partial ordering) и неопределенное упорядочение (uncertain ordering). В первом случае алгоритм программируется на принятие однозначных решений только между частью элементов, но не всеми. Например, автономное оружие будет делать выбор в пользу своих солдат перед вражескими и в пользу гражданского населения перед вражескими солдатами. Но выбор между своими солдатами и гражданским населением не программируется.

Во втором случае у алгоритма есть несколько списков с абсолютными предпочтениями, но к каждому из них прикреплена вероятность. Например, в 75% случаев алгоритм сделает выбор в пользу своих солдат перед гражданским населением и вражескими солдатами. А в 25% случаев выбор будет сделан в пользу гражданского населения в ущерб своим солдатам и вражеским солдатам.

Алгоритм сможет учитывать имеющуюся неопределенность и предоставлять людям несколько решений с соответствующими компромиссами. Например, в медицине, вместо того, чтобы рекомендовать одно лечение вместо другого, он мог бы представить три возможных варианта: один для максимизации продолжительности жизни пациента, другой для минимизации страданий пациента и третий для минимизации затрат.

«Пусть система будет явно неуверенной и передаст решение этической проблемы людям» — отмечает автор.

«Есть много ситуаций с высокими ставками, когда на самом деле неуместно и даже опасно программировать в одной целевой функции» — говорит Эскерли. Программирование неопределенности поможет избежать этических парадоксов. В тоже время, люди будут получать математически просчитанные варианты действий с учетом большинства значимых факторов, что поможет принятию взвешенных решений.