При решении задач машинного обучения разработчики подбирают архитектуры нейросетей вручную. Это трудно и занимает много времени. IBM создали алгоритм, который ускоряет поиск рациональной структуры нейросети. При этом ошибка увеличивается всего на 0,6%, а скорость обучения сокращается до 50,000 раз.

Для ускорения подбора разработчик подхода, Martin Wistuba, использовал эволюционные алгоритмы. По его словам «этот подход существенно сокращает время обучения сети».

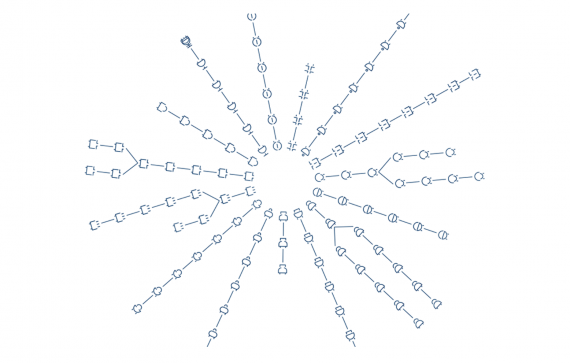

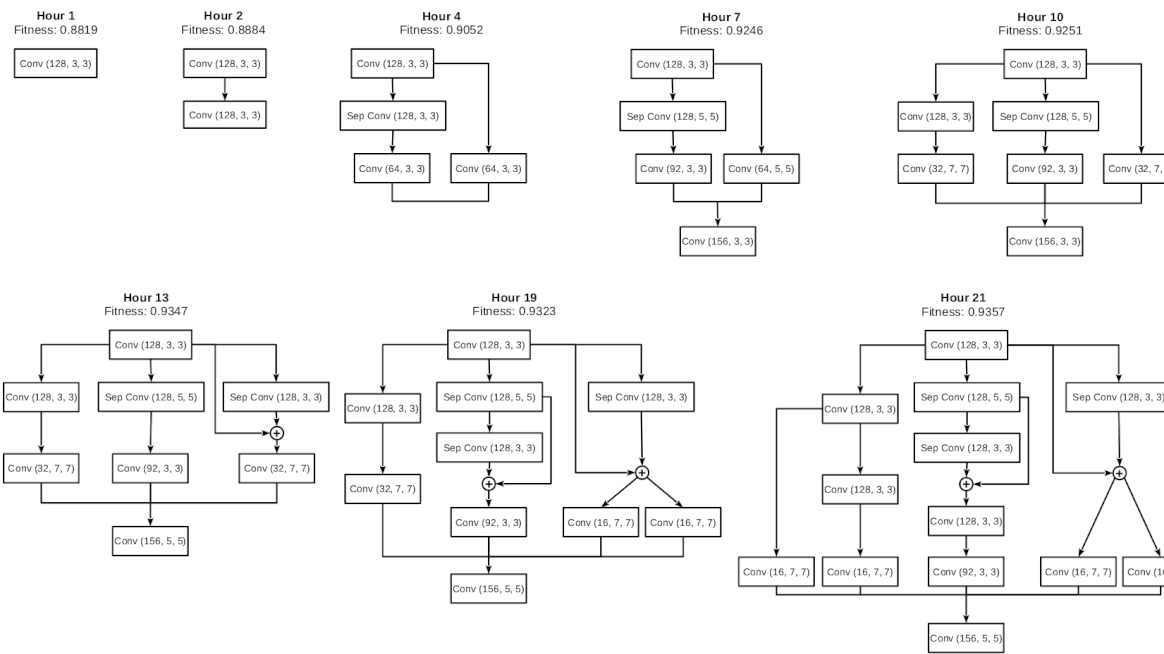

В основе эволюционного подхода лежит идея применения методов случайного подбора. Сверточная нейронная сеть «эволюционирует» с помощью случайных мутаций, пока не будет достигнута нужная точность. Подход улучшает производительность нейронной сети и сокращает время обучения. Архитектура сети может меняться и усложняться непрерывно.

Работу алгоритма сравнили с другими подходами, протестировав его на задачах классификации изображений с помощью датасетов CIFAR-10 и CIFAR-100 с размеченными изображениями. В результате время обучения сети сократилось в 50000 раз по сравнению с некоторыми подходами, а ошибка выросла всего на 0,6%.

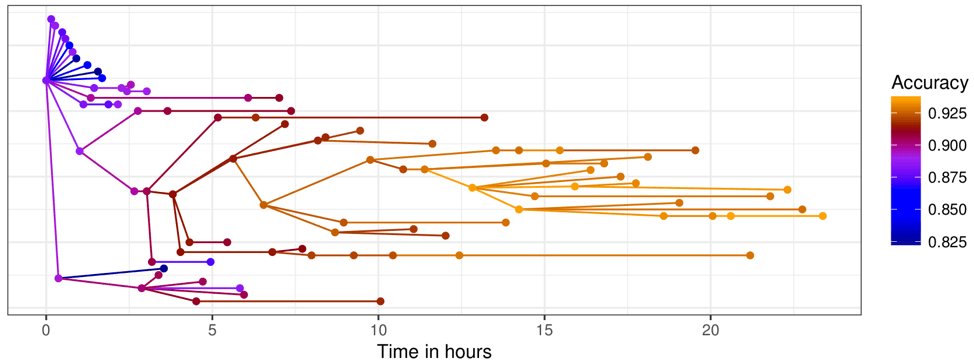

Схема демонстрирует процесс оптимизации нейросети и снижения error rate во времени. Некоторые из этапов пропущены.

В будущем алгоритм интегрируют в облачные сервисы IBM.