Модель AlphaStar от DeepMind обучилась играть в StarCraft II на уровне Грандмастера. В общем рейтинге модель обошла 99.8% активных игроков. Уровень Грандмастера был достигнут для всех трех типов игроков: Protoss, Terran и Zerg. В начале года AlphaStar соревновалась против двоих лучших игроков в StarCraft II.

4 отличия текущего исследования

Текущее исследование отличается от предыдущего следующим:

- AlphaStar теперь играет с теми же ограничениями, с какими играют обычные люди. Ограничения включают в себя ограниченный обзор и ограничение частоты действий;

- Модель обучили играть один-на-один за и с такими игроками, как Protoss, Terran и Zerg. Каждый вид игрока представляет собой отдельную нейросеть;

- Обучение полностью автоматизировано и включает только агентов, которые были обучены на размеченных данных, а не на данных предыдущих агентов;

- Система обучается на официальном сервере игры с использованием тех же карт и условий, которые доступны обычным игрокам. Записи игр системы доступны по ссылке

Исследователи выбрали использовать нейросети, обучение с подкреплением, мультиагентное обучение и имитационное обучения, чтобы обучить модель напрямую на данных игры. Игра в такие игры, как StarCraft, требует от агентов устойчивости и адаптивности при принятии решений. На каждом временном шаге у агента 10^26 возможных вариантов действий. Обученные на сложных играх модели могут масштабироваться для решения задач из реальной жизни.

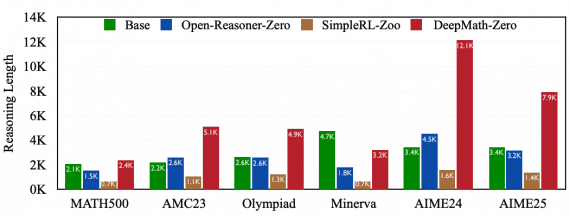

Результаты работы AlphaStar представлены ниже.