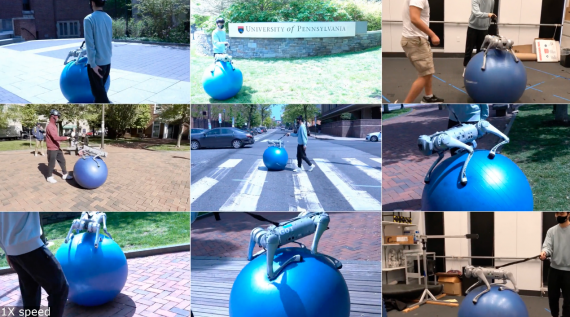

Исследователи из UC Berkley обучили робота имитировать поведение собаки с помощью обучения с подкреплением. Предложенный фреймворк масштабируется на другие виды животных. Модель получает на вход видеоролик с записью движения животного. На основе входного ролика RL-агент выучивает политику контроля движений, которая позволяет ему имитировать движение. Поддержка других видов движения добавляется аналогично. Исследователи обучили RL-агента выполнять такие действия, как поворот, быстрая ходьба и прыжок. Политики агент выучивает в симуляции. Затем модель переносится в реальный мир с помощью метода адаптации скрытого пространства, который позволяет адаптировать политику к реальной среде на основе коротки видеозаписей реального робота.

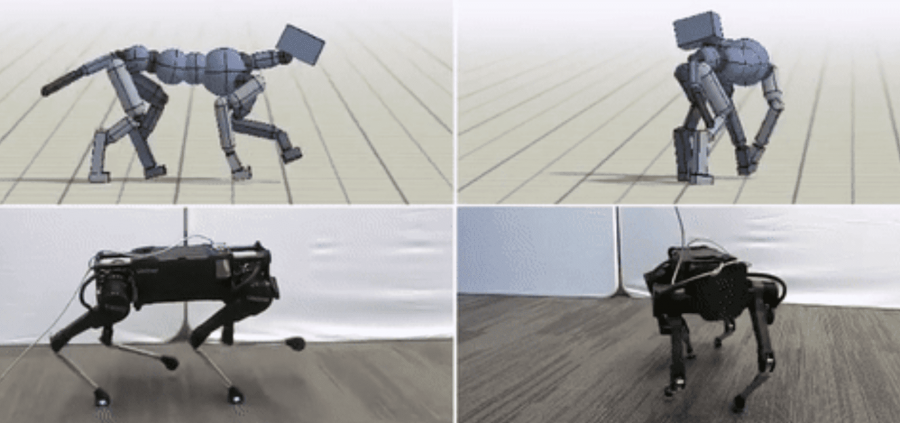

Архитектура фреймворка

Предложенный фреймворк состоит из трех этапа:

- Переоценка движения, во время которой движения животного на входной видеозаписи соотносятся с движениями робота;

- Имитация движения, когда выход из первого этапа используется для обучения политики имитации движения агента;

- Адаптация к реальной среде, когда обученная модель из симуляции переносится на реальную среду

В качестве робота использовали модель четвероногого робота от Laikago.

Проверка работы алгоритма

RL-агент способен выучивать различные типы движений собаки. Среди типов движений — разные виды ходьбы, включая бег рысью или неспешный шаг, и быстрые повороты. Если обучать агента на видеозаписях с ходьбой, отмотанных в обратную сторону, то робот научается ходить назад.