Исследователи из Google Brain разработали метод для обучения роботов управлять рукой. Для обучения робота используется алгоритм planning with deep dynamics models (PDDM). На модели руки 24-DoF модель обучили управлять несколькими объектами сразу. Обучалась модель на видеоданных реальных действий руками от 2 до 4 часов.

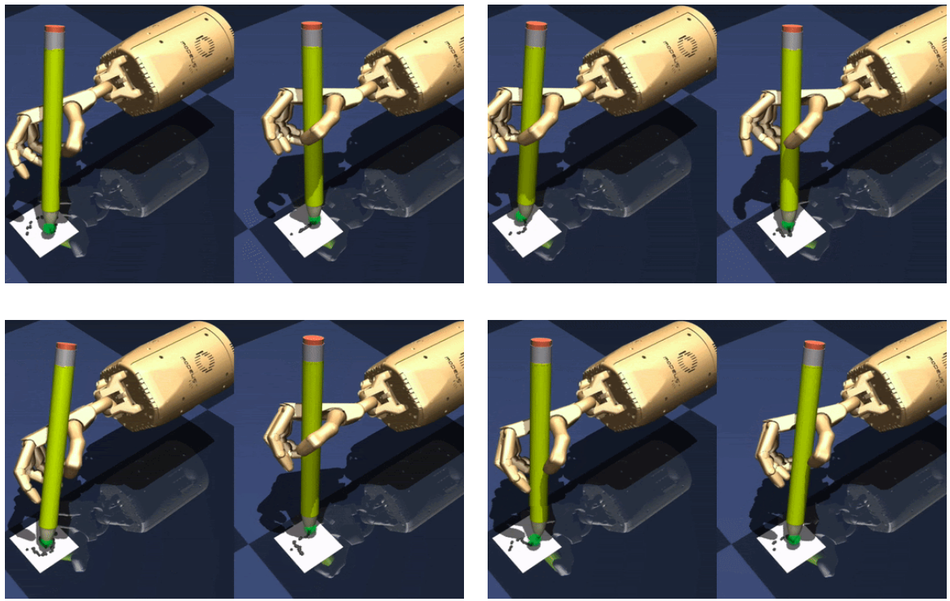

Умение использовать руки с несколькими пальцами позволят роботам выполнять широкий спектр задач, которые связаны с манипулированием объектами. Однако множество более комплексных типов действий сложно контролировать. Такие действия включают в себя письмо, передвижение объекта и манипулирование объектом. Текущие решения для обучения робота либо требуют большого количества данных для обучения, либо не способны масштабироваться на более комплексные задачи. Именно поэтому исследователи предлагают PDDM.

Как работает PDDM

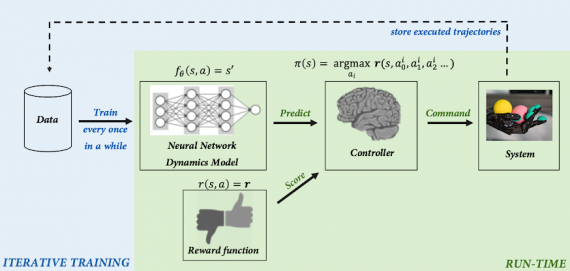

На высоком уровне онлайн PDDM задействует итеративную процедуру, которая состоит из следующих шагов:

- Контроллер используется для отбора действий из предсказаний обученной нейросетевой модели (dynamics model);

- Нейросеть обучается на собранных данных реального мира

Задача перекатывания шариков

Задача состоит в том, чтобы балансировать двумя шарами одновременно и перекатывать их в одной руке. Сама задача берет начало из китайских практик для релаксации (Baoding balls). Эта задача требует навыков координации и ловкости. PDDM алгоритм тестируется через обучению перекатыванию шаров. В качестве данных для обучения используется двухчасовой набор видеозаписей. При этом не задействуются симуляции действий. В экспериментах используется рука ShadowHand: A 24-DoF с 5 пальцами. Отдельно для каждого сустава тренировались трекеры для предсказания 3D позиции шаров. Архитектура трекеров основывалась на dilated CNN.

Результаты эксперимента

При обучении модели на двухчасовых данных количество успешных действий достигло 80%. Когда обучающую выборку увеличили до 4 часов, модель научилась поворачивать шары на 90 градусов с 100% точностью.