У больших языковых моделей (LLM) есть «грязный секрет»: до сих пор остается загадкой, насколько велик углеродный след этих моделей. AI-стартап Hugging Face разработал способ оценки выбросов, производимых в течение всего жизненного цикла модели, а не только во время обучения. Работа Hugging Face опубликована в статье.

Для проверки нового подхода к расчету углеродных выбросов, Hugging Face оценила общие выбросы своей open source языковой модели BLOOM, которая была выпущена в июле 2022 года. Процесс оценки состоит из нескольких этапов:

- подсчета количество энергии, используемой для обучения модели на суперкомпьютере;

- энергии, необходимой для производства аппаратного обеспечения суперкомпьютера и обслуживания его вычислительной инфраструктуры;

- энергии, используемой для работы BLOOM после того, как она была развернута. Исследователи рассчитали последнюю часть с помощью программного инструмента CodeCarbon, который отслеживал выбросы углекислого газа, производимые BLOOM, в режиме реального времени в течение 18 дней.

Результаты исследования

Hugging Face подсчитал, что обучение BLOOM привело к выбросу 25 тонн углекислого газа. Но исследователи обнаружили, что эта цифра удвоилась, принимая во внимание выбросы, создаваемые во время производства «железа», используемого для обучения, и энергии, необходимой для фактического запуска BLOOM после его обучения.

50 тонн выбросов эквивалентны 60 рейсам между Лондоном и Нью-Йорком — это значительно меньше, чем выбросы, связанные с другими LLM того же размера. Это связано с тем, что BLOOM обучалась на французском суперкомпьютере, который в основном питается от ядерной энергии и не производит выбросов углекислого газа. Модели, обученные в Китае, Австралии или некоторых частях США, где энергетические сети в большей степени зависят от ископаемого топлива будут сильнее загрязнять окружающую среду.

После запуска BLOOM Hugging Face подсчитала, что при использовании модели выбрасывалось около 19 кг углекислого газа в день, что аналогично выбросам, возникающим при проезде около 86 километров на легковом автомобиле последних годов выпуска.

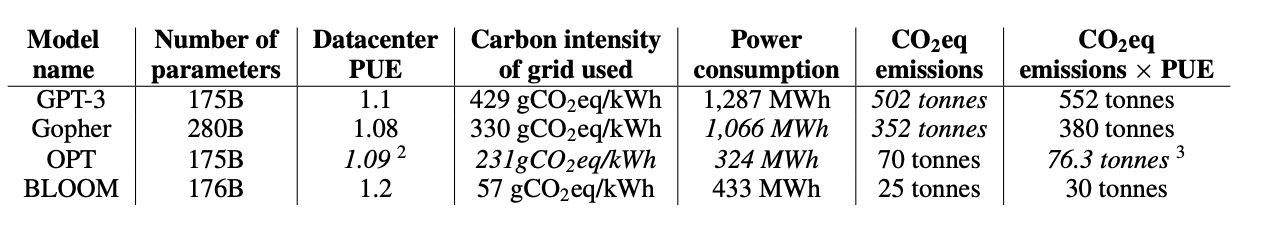

Для сравнения, языковые модели GPT-3 и OPT, по оценкам, во время обучения выделяют 502 и 70 тонн углекислого газа соответственно:

Огромные выбросы GPT-3 можно частично объяснить тем, что она была обучена на более старом, менее эффективном оборудовании. Но трудно сказать, каковы цифры наверняка: не существует стандартизированного способа измерения выбросов углекислого газа, и эти цифры основаны на внешних оценках или, в случае с OPT, на ограниченных данных, опубликованных компанией.

«Наша цель состояла в том, чтобы учесть большую часть жизненного цикла и помочь общественности лучше понять влияние разработки ИИ на окружающую среду и как мы можем уменьшить выбросы», — говорит Саша Лучони, исследователь Hugging Face. По словам Лучони, исследование должно побудить людей перейти к более эффективным способам проведения исследований в области ИИ, таким как «fine tuning» моделей вместо создания моделей еще большего размера.

Афторы не пробовали посчитать углеродный след бетховинов? Или углеродный след венды, особенно когда за ней сидят игродрочеры.

О, есть занятие людям. Когда-то их коллеги строчили диссертации на темы типа − влияние трудов классиков марксизма-ленинизма на советское машиностроение.