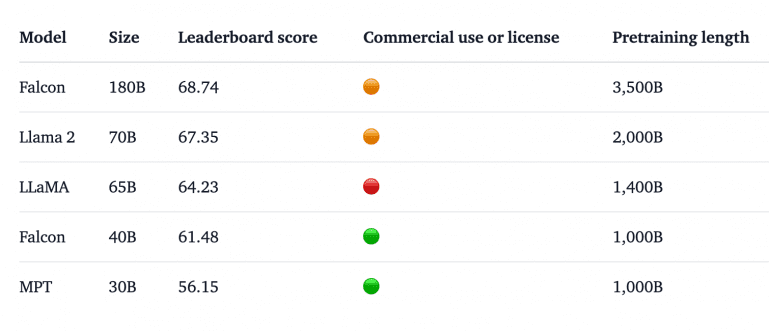

Институт Технологических Инноваций из ОАЭ представил Falcon 180B — крупнейшую открытую языковую модель, потеснившую Llama 2 с первого места в рейтинге предобученных open-access языковых моделей от HugginFace. Модель была обучена на 3,5 триллионах токенов с использованием датасета RefinedWeb. Falcon содержит 180 миллиардов параметров — в 2,6 раза больше, чем у предыдущего лидера — Llama 70B, что потребует 8 Nvidia A100 GPU и 400GB пространства для инференса. Демо модели можно потестировать на HuggingFace, там же доступен и код модели.

Архитектура и обучение модели

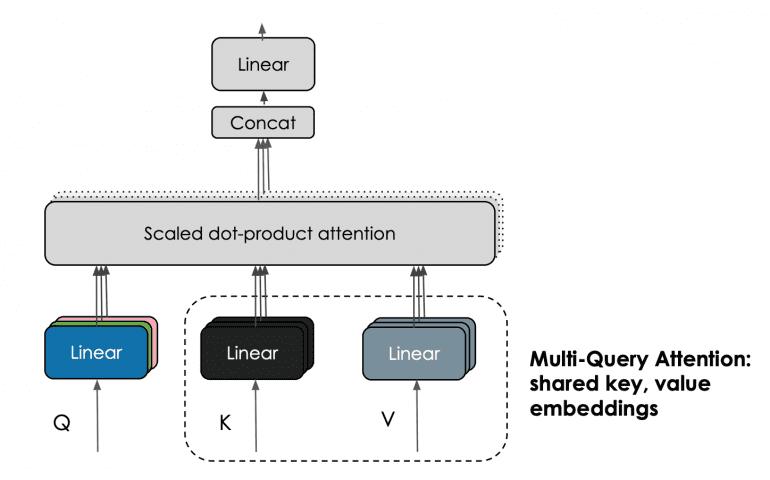

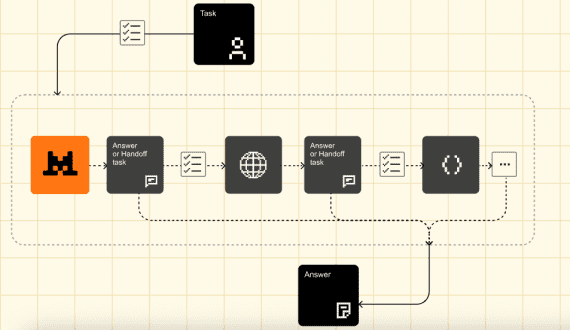

Falcon 180B — дообученная модель Falcon 40B, использует multi-query механизм внимания для улучшенной масштабируемости. Схема ванильного многоголового (multi-head) внимания имеет один запрос (query), ключ (key) и значение (value) на каждую голову (head); в то время как множественный запрос (multiquery) вместо этого использует один ключ и значение для всех «голов».

Модель обучалась на 4096 GPU, что потребовало около 7 000 000 часов GPU на Amazon SageMaker. По сравнению с Llama 2, для обучения Falcon 180B использовалось в 4 раза больше вычислительной мощности.

Датасет для Falcon 180B в основном состоит из веб-данных из набора данных RefinedWeb (~85%). Также использовались отобранные данные: диалоги, технические статьи и код, что делает его универсальной моделью для задач NLP (~3%).

Результаты Falcon 180B

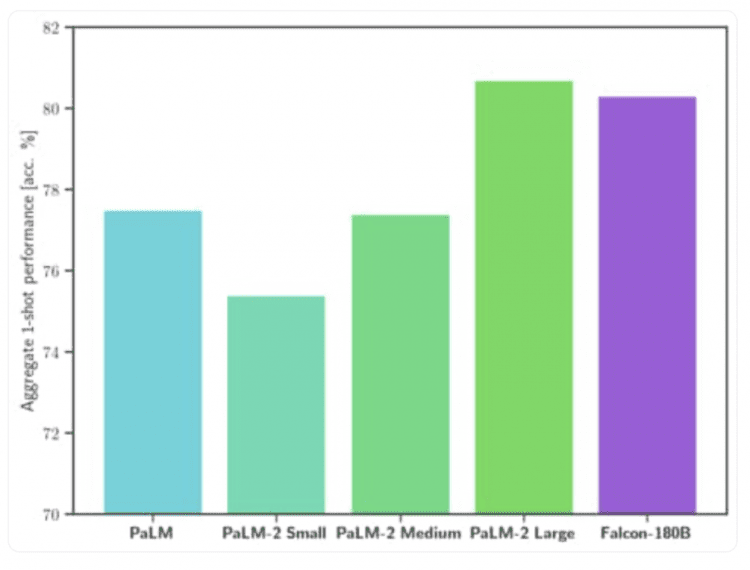

Falcon 180B превосходит Llama 2 70B и GPT-3.5 от OpenAI на бенчмарке MMLU, уступая GPT-4. Также она успешно конкурирует с проприетарной PaLM 2-Large от Google на бенчмарках HellaSwag, LAMBADA, WebQuestions, Winogrande, PIQA, ARC, BoolQ, CB, COPA, RTE, WiC, WSC и ReCoRD:

Хотя Falcon 180B доступен на Hugging Face Hub, его коммерческое использование очень ограничено. Рекомендуется ознакомиться с лицензией и проконсультироваться с юридическими службами для коммерческих целей.

Галлюционирует на первом же вопросе. После пятого скатывается на бред, состоящий из бессмысленного набора слогов.

Да, тот же результат.

Возможно вы провоцируете модель, задавая ей галлюцинирующие вопросы. А как известно в профессиональных кругах, каков вопрос таков и ответ.

Не знаю, gpt 3.0 было сложновато заставить тупить. Не знаю как дела обстоят сейчас.

Та же самая ерунда. Попросил его рассказать о себе, а он мне в ответ и говорит, что создан компанией Yandex. На русском языке работает ужасно. Короче, то, что он превосходит… Подробнее »

По русски тупит жестко, но на английском норм. На русском хуже чембыл davinci-002

Почему-то по ссылке недоступен интерфейс модели, чтобы задать вопрос. Где смотреть?

https://huggingface.co/spaces/tiiuae/falcon-180b-demo