OpenAI сообщила о создании GPT-4 – обновленной версии GPT-3.5, способной принимать на вход изображения и сдающей экзамены лучше 90% студентов. Модель уже доступна для использования подписчикам ChatGPT Plus и интегрирована в чат-бот поисковой системы Bing.

В OpenAI утверждают, что качество ответов модели на простые вопросы почти не увеличилось по сравнению с GPT-3.5, однако на сложных запросах GPT-4 демонстрирует большие точность и стабильность. В частности, разработчики значительно повысили память модели (до 32 768 токенов), что позволяет ей вести продолжительные диалоги.

Особенности GPT-4

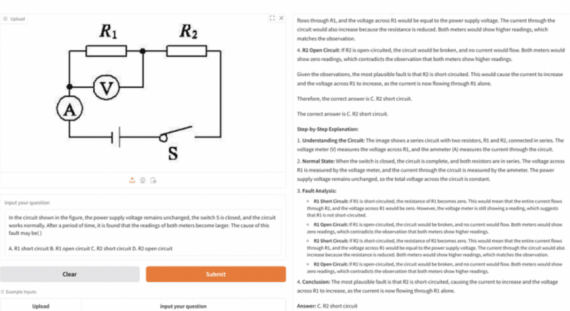

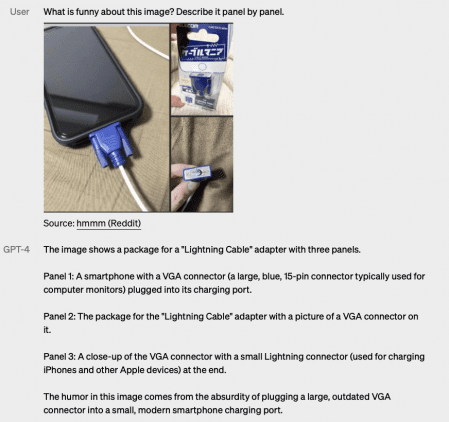

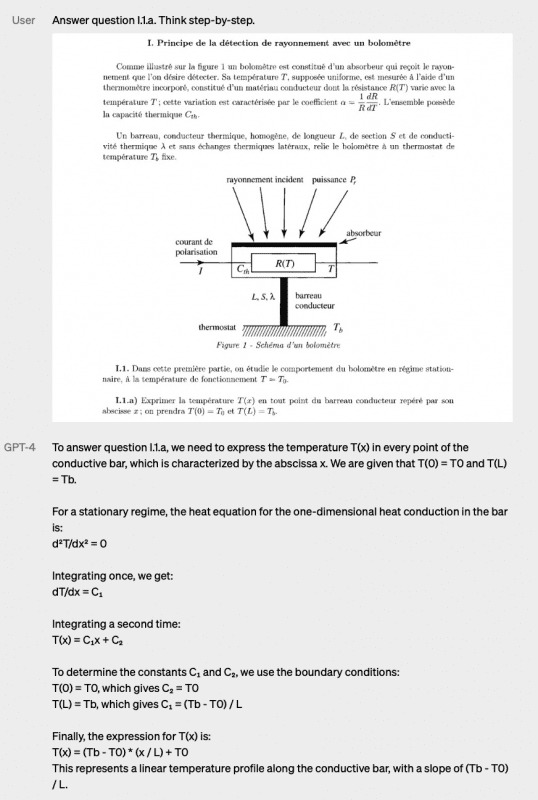

Ключевой особенностью GPT-4 является ее мультимодальность, то есть возможность принимать на вход не только текст, но и изображение. Например, можно попросить ее объяснить смысл мема на изображении, перевести текст на фото или решить задачу по физике из скриншота. Выходным результатом модели, тем не менее, является только текст.

Разработчикам также удалось на 40% снизить частоту «галлюцинаций» модели (придумывание несуществующих фактов) и увеличить количество поддерживаемых языков до 26. GPT-4 была протестирована на нескольких десятках экзаменов, в том числе по математике, адвокатскому праву и биологии. В среднем, модель сдавала эти экзамены на 90% лучше студентов.

Модель доступна подписчикам ChatGPT Plus с ограничением – 100 запросов в одном четырехчасовом слоте. Для доступа к API GPT-4 необходимо записаться в список ожидания. Модель уже используется в ряде продуктов партнеров OpenAI, включая Bing и Duolingo.