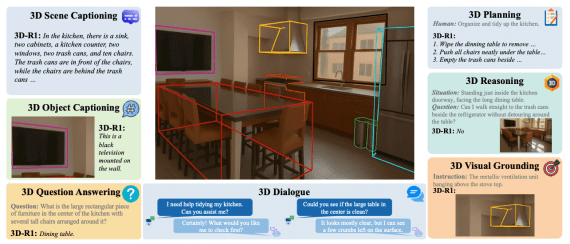

Разработанный в MIT алгоритм DenseAV обучается понимать значение слов и предложений, просматривая видео с разговорами людей. DenseAV превзошел другие алгоритмы в задачах идентификации объектов по их названию.

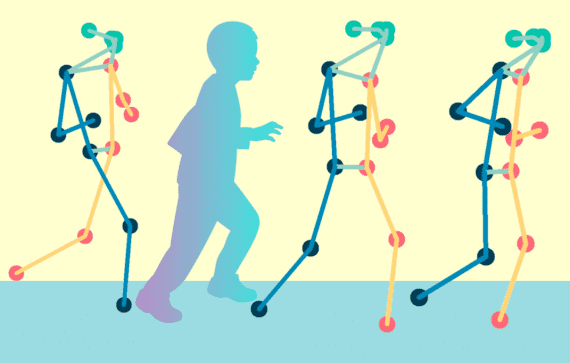

Исследователи решили задачу изучения языка без ввода текста. Другими словами, их подход основан на том, как дети учатся понимать язык, наблюдая за окружающим миром. DenseAV предсказывает, что человек видит, исходя из того, что он слышит, и наоборот. Например, если человек слышит, как кто-то произносит фразу «выпекайте пирог при 350 градусах», скорее всего, он видит торт или духовку.

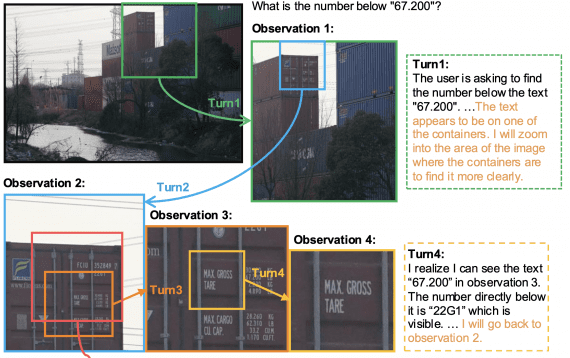

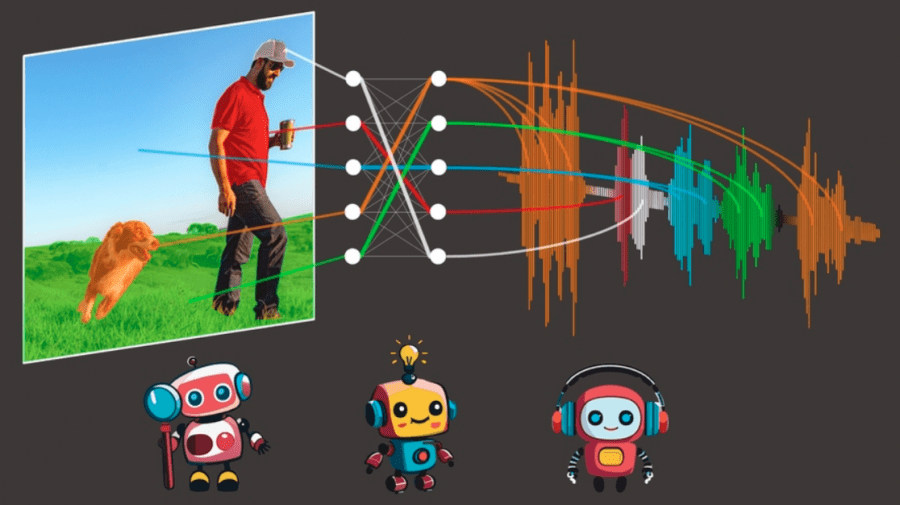

DenseAV использует два компонента для раздельной обработки аудио- и визуальных данных. Это заставляет алгоритм распознавать объекты и создавать подробные и значимые признаки как для звуковых, так и для визуальных сигналов. DenseAV обучается, сравнивая и объединяя все возможные совпадения между аудиоклипом и пикселями изображения.

Алгоритм был обучен на датасете AudioSet, который включает в себя 2 миллиона видеороликов из YouTube. Исследователи также создали новые датасеты, чтобы проверить, насколько хорошо модель может связывать звуки и изображения. В этих тестах DenseAV превзошел существующие SotA-модели.

Ключевое применение алгоритма – обучение моделей на основе большого количества видео, публикуемых в Интернете. Другое возможное приложение – изучение языков животных, таких как дельфинов или китов, которые не имеют письменной формы общения. Также метод может быть использован для выявления закономерностей между другими парами сигналов, такими как сейсмические сигналы и соответствующие им геологические процессы.