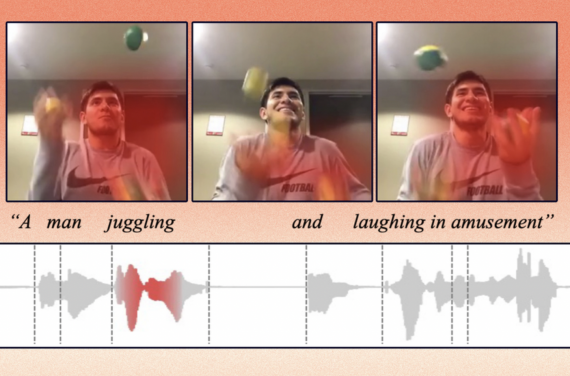

Модель обучили понимать язык с помощью видеозаписей

23 июня 2024

Модель обучили понимать язык с помощью видеозаписей

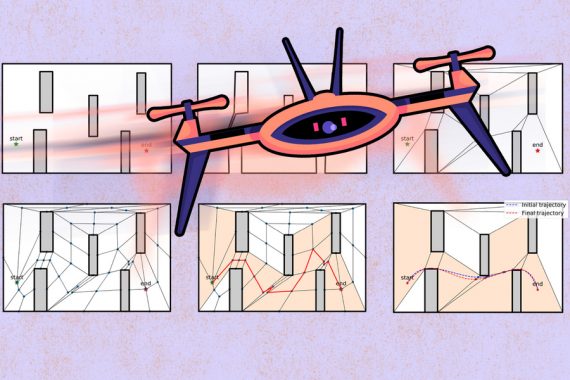

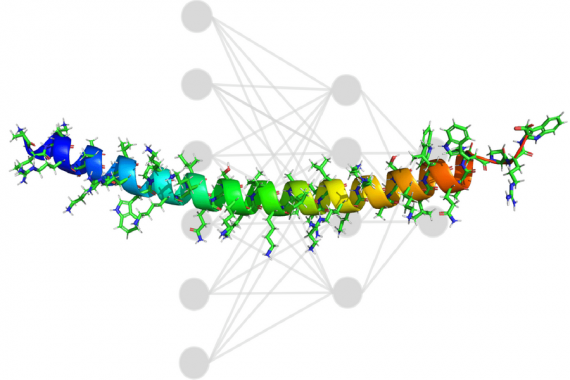

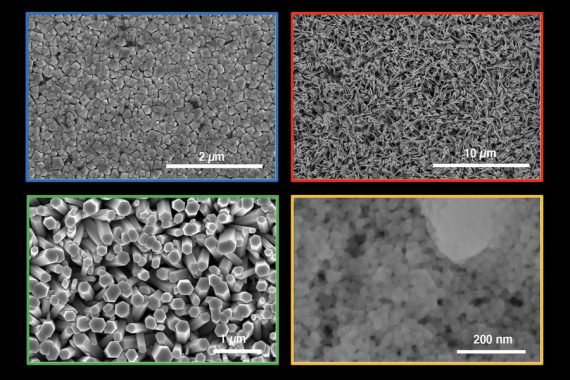

Разработанный в MIT алгоритм DenseAV обучается понимать значение слов и предложений, просматривая видео с разговорами людей. DenseAV превзошел другие алгоритмы в задачах идентификации объектов по их названию. Исследователи решили задачу…