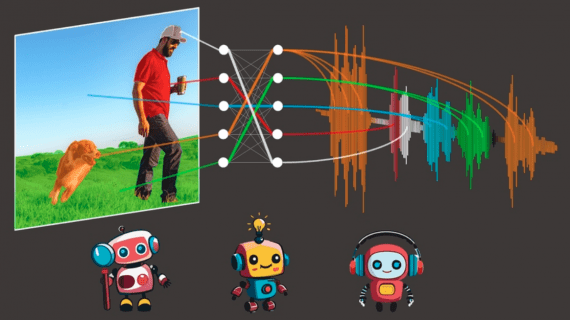

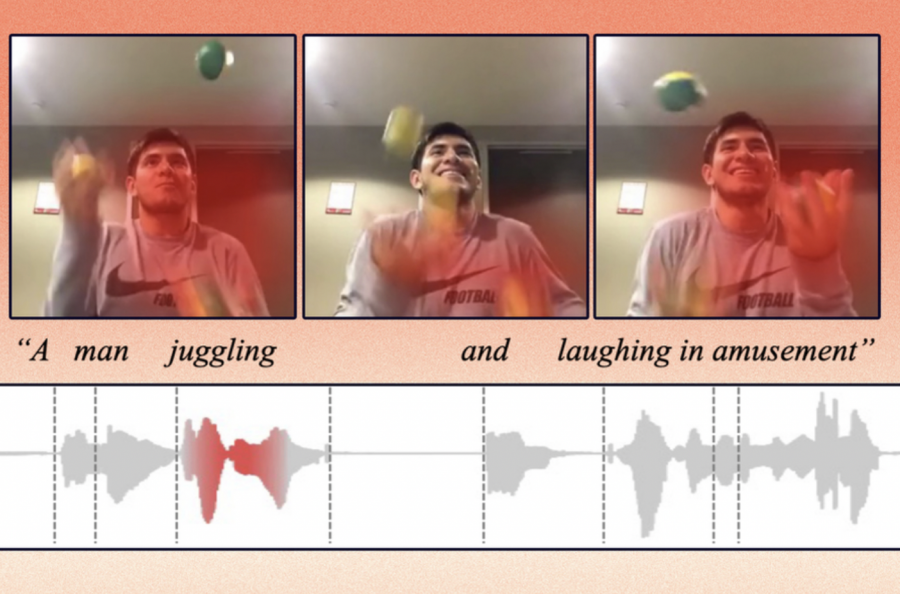

В MIT разработали модель кросс-модального поиска действий в текстовом, аудио- и видеоконтенте. Модель позволяет определить, где в видео происходит определенное действие, и идентифицировать его.

Алгоритм обучен представлять данные таким образом, чтобы фиксировать концепции, которые являются общими для визуальной, звуковой или текстовой модальностями. Например, их метод позволяет узнать, что плачущий ребенок в видео связан с произнесенным словом “плач” в аудиозаписи.

Модель была протестирована в задачах кросс-модального поиска на трех парах датасетов: датасете с видеозаписями и текстовыми подписями к ним, датасете озвученных видео и датасете с одним кадром из видео и его полным звуковым файлом.

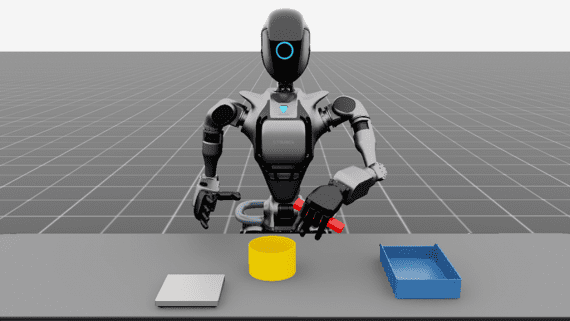

Технологию планируется применить для обучения роботов распознаванию концепций схожим образом с тем, как это делают люди. Особенностью модели, вытекающей из ее идеи – выделение общих связей в кросс-модальном контенте, – является интерпретируемость ее результатов, что важно для задач робототехники.