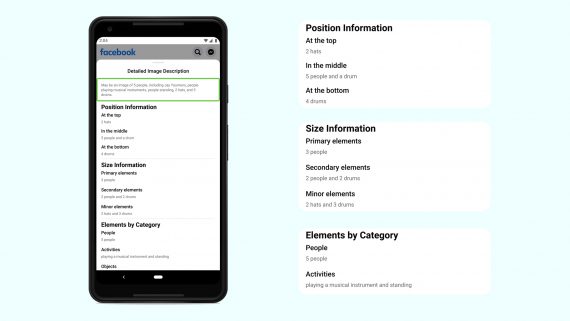

Нейросеть от FAIR генерирует описания к фотографиям для пользователей с проблемами зрения. Система использует распознавание объектов, чтобы генерировать текстовые описания изображения. В качестве архитектуры модели использовали Faster R-CNN из Detectron. Итоговая нейросеть распознает 1200 классов объектов.

Зачем это нужно

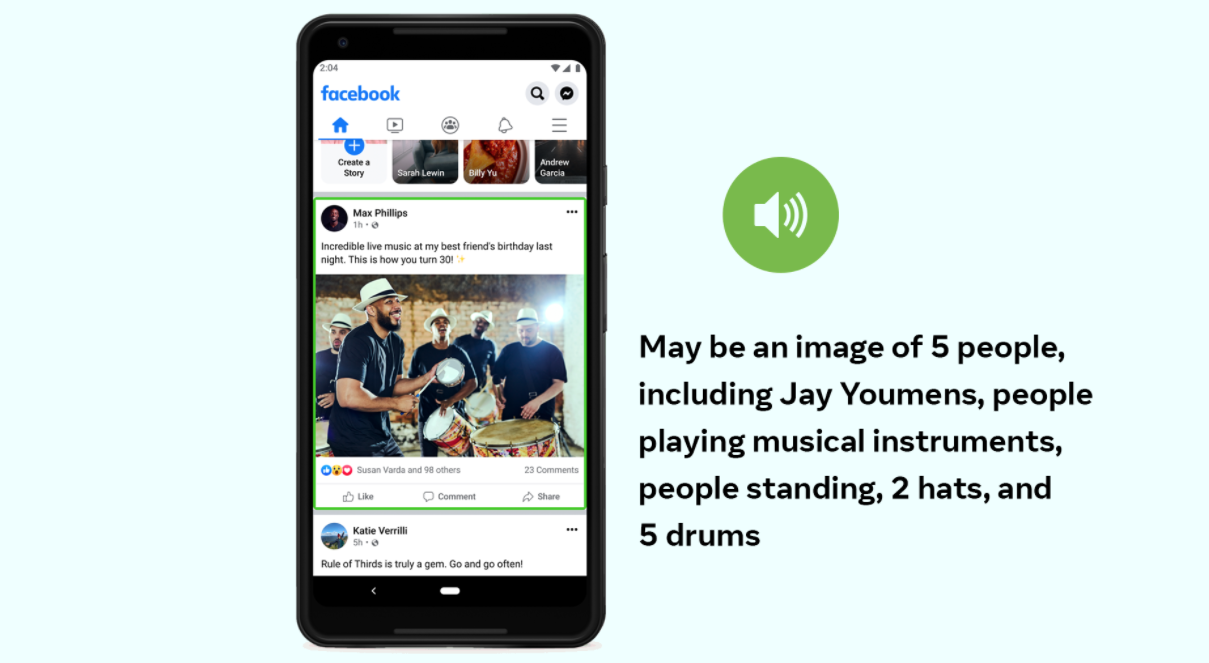

Когда пользовать пролистывают новостную ленту, они могут столкнуться с фотографиями. Часть пользователей не может сразу распознать содержание изображения. Пользователи с проблемами зрения могут воспринимать содержание изображения с помощью текстовых описаний сцены (альтернативного текста). Однако большая часть изображений не имеет текстового описания. Для таких случаев в FAIR разработали систему автоматического альтернативного текста (AAT).

Обновления в AAT

В обновленной версии система AAT распознает в 10 раз больше классов объектов. Кроме того, сами описания более детализированы и включают действия, знаки, виды животных и другое. Пример описания: “Селфи двух людей на улице напротив Пизанской башни”.

Разработчики отошли от формата обучения с учителем, чтобы увеличить количество классов объектов, которые модель способна распознать, и снизить затраты на разметку. Изначально AAT модель распознавала только 100 объектов. Обновленную модель обучали на миллиардах открытых изображениях в Instagram и их хэштегах. Затем модель дообучали на данных из разных стран с переводом хэштегов на разные языки. Кроме того, нейросеть тестировали на наличие скрытых смещений относительно гендера, цвета лица и возраста.