Модель Code Llama — дообученная Llama 2 для написания, завершения и исправления кода, распространяемая бесплатно для коммерческих и исследовательских целей. Code Llama ускоряет написание кода, снижает порог входа для начинающих разработчиков и упрощает написание документации к коду. Модель поддерживает языки Python, C++, Java, PHP, Typescript (Javascript), C#, Bash и другие.

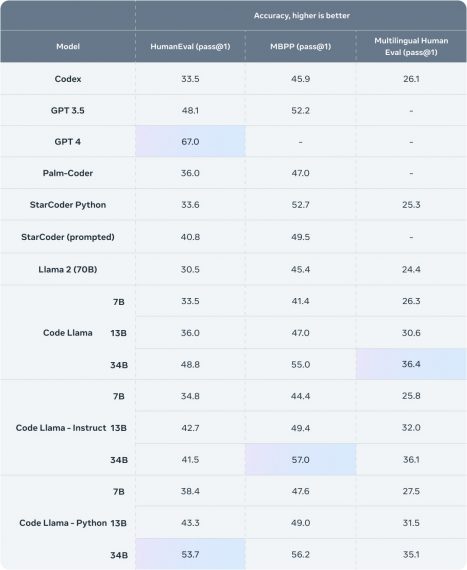

Code Llama достигла state-of-the-art результатов на бенчмарках HumanEval и MBPP в том числе благодаря увеличенному контексту Llama 2, что позволило модели изучать связи между непоследовательными частями кодовой базы и, как следствие, обучаться на масштабных датасетах.

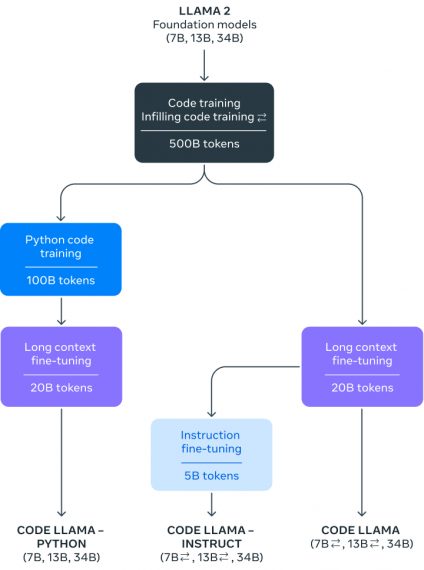

Исследователи опубликовали модели с 7, 13 и 34 миллиардами параметров. Модели 7B и 13B, обученные на 500 миллиардах токенов, поддерживают задачи дополнения и завершения кода «из коробки». Модель 34B показывает лучшую точность, однако, менее масштабные версии 7B и 13B лучше справляются с внесением правок в код «на лету» и другими задачами, где требуется быстрый отклик. Нужно отметить, что модель 7B запускается на одном GPU.

Code Llama Python и Code Llama Instruct

Кроме того, разработчики выложили еще две дообученные модели:

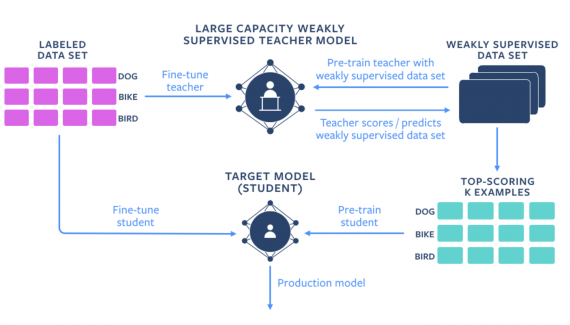

- Code Llama Python дообучилась на 100 миллиардах токенов с Python кодом. Акцент был сделан именно на этом языке, потому что Python и Pytorch играют большую роль в развитии ИИ-разработки.

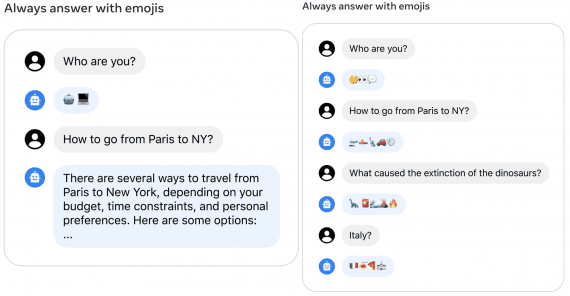

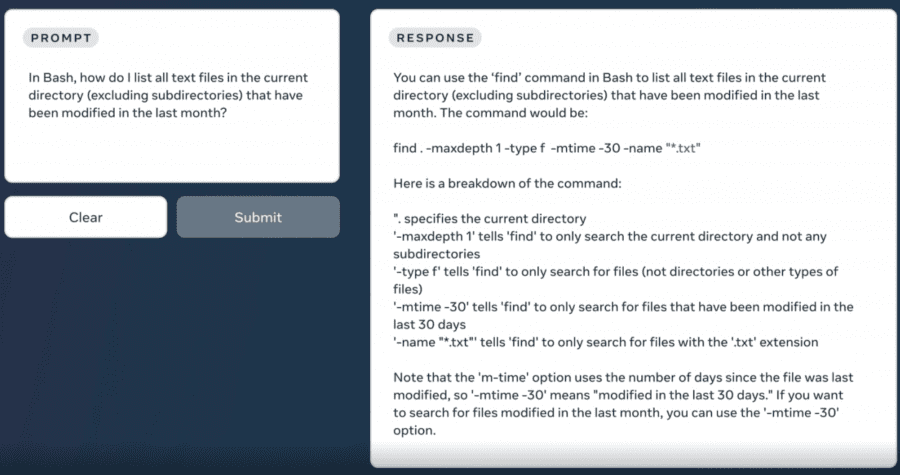

- Code Llama Instruct обучили принимать запросы и выдавать ответы на естественном языке, чтобы объяснять детали и выдавать подсказки при написании кода. Так модель лучше обучается понимать промпты. Исследователи советуют использовать ее параллельно с другими моделями.

Как использовать модель

Есть несколько способов уже сейчас начать использовать модель:

- Запросить доступ на официальном сайте, где можно скачать модель и веса. Как запустить инференс модели описано в репозитории на Guthub. Ссылка на скачивание модели актуальна в течение 24 часов после одобрения запроса, поэтому если вы увидите ошибку 403, запросите доступ заново.

- Запустить демо модели 13B и 13B Instruct на HuggingFace;

- В режиме чат-бота испытать версию 34B на сайте PerplexityAI;

- С помощью расширения «Continue» для VS Code вы можете использовать Code Llama в качестве альтернативы GPT-4, как на локальной машине с Ollama или TogetherAI, так и через Replicate.