Модель, совместно разработанная Microsoft и MIT, выявляет «слепые зоны» в обучении беспилотных автомобилей. Инженеры планируют использовать ее для повышения безопасности автономных автомобилей и роботов.

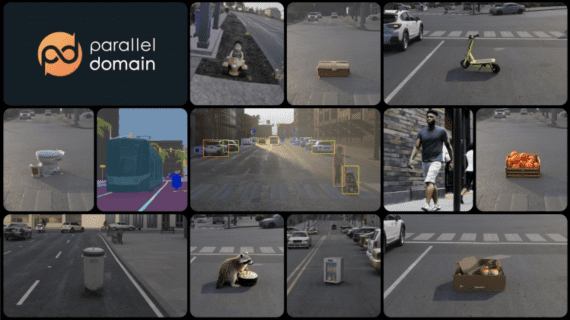

Симуляция городской среды не может охватить все возможные ситуации на дороге, что приводит к непредвиденным ошибкам в реальных условиях. Если автономный автомобиль не обучен различать большие белые машины и машины скорой помощи, то в реальной жизни он никак не узнает о том, что следует съехать с дороги на обочину и пропустить скорую. Таких сценариев больше, чем можно себе представить.

Поиск «слепых зон»

Для выявления «слепых зон» исследователи предложили обучить модель, используя человеческий опыт. Человек внимательно следил за поведением модели и обеспечивал обратную связь, когда она допускала ошибки. Затем исследователи объединили данные обучения и обратной связи и создали модель, которая определяет ситуации, в которых потребуется больше информации о том, как правильно действовать.

«Модель поможет алгоритмам управления автомобилем понять, что они еще не знают. Такой подход может изменить процесс обучения автономного транспорта» — отмечают авторы статьи.

Человек обучает модель, демонстрируя «правильное» поведение. Модель следить за поведением человека и в симуляции и на реальной дороге, сравнивая со своим. Когда действия человека отличаются от выбора действий алгоритма, компьютер подает сигнал. Несовпадения в действиях станет признаком, что ситуация потенциально опасна, и модель обратит на неё внимание.

Механизм внимания

Ученые проверили метод на видеоиграх. Человек в симуляции корректировал путь персонажа на экране. В это время модель собирала информацию о потенциально опасных ситуациях — тех, в которых алгоритмы обычно не знают как действовать или действуют неправильно.

В случае со скорой помощью, человек может 10 раз проехать мимо нее спокойно, но на 11 раз, когда у скорой будет включена сирена — повести себя по-другому. Модель получит противоречивые сигналы об одной и той же ситуации с большой белой машиной. Конечная цель состоит в том, чтобы двусмысленные ситуации были обозначены как «слепые зоны». То есть, модель сама будет понимать, в каких ситуациях у автомобиля есть вероятность совершить ошибку.

В конце концов, алгоритм создаст тепловую карту, где каждой ситуации из первоначального обучения в симуляции присваивается низкая или высокая вероятность того, что она будет «слепой зоной» для автономного автомобиля.

«Автономные автомобили могут использовать эту обученную модель, чтобы действовать более осторожно и разумно. Если изученная модель предсказывает, что определенная ситуация является «слепой зоной» с высокой вероятностью, автомобиль может запросить человека о приемлемом действии, обеспечивающем более безопасное выполнение», — говорят авторы.