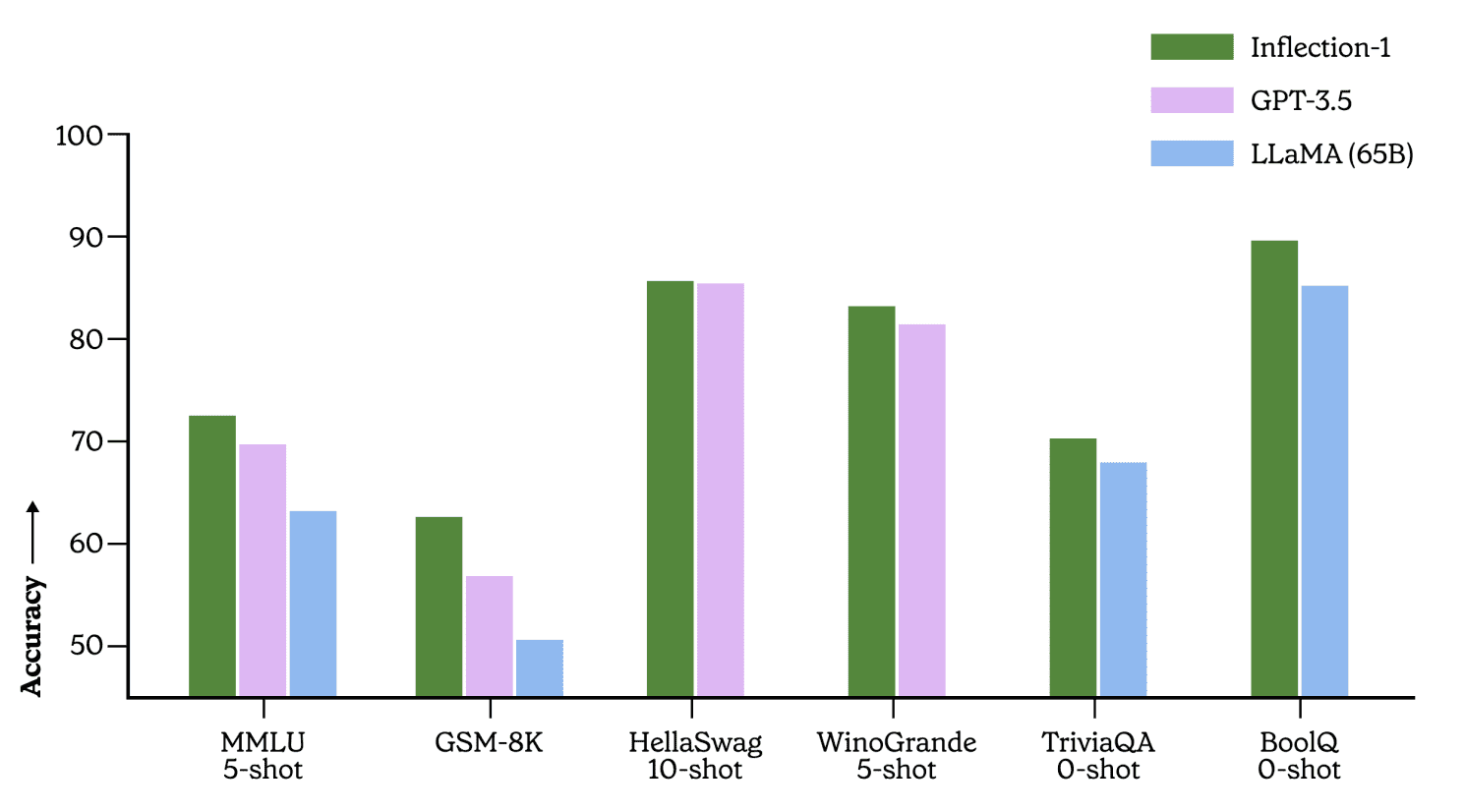

Стартап Inflection официально представил Inflection-1 — большую языковую модель, на которой основан чат-бот Pi. Размер и возможности модели сопоставимы с GPT-3.5 (на которой основан ChatGPT), а обучение проводилось «на тысячах» GPU Nvidia H100, что сопоставимо с вычислительной мощностью, используемой для обучения моделей Open AI и Google. В опубликованной статье приведены результаты экспериментов. Inflection-1 конкурентоспособна или даже превосходит GPT-3.5, LLaMA, Chinchilla и PaLM-540B в решении отдельных задач.

Результаты Inflection-1

Результаты свидетельствуют о хорошей производительности Inflection-1 в решении экзаменов средней и старшей школы и логических задач, например, «если Ваня бросил мяч на крышу, а Женя кинул его обратно, где находится мяч?». Однако модель не столь успешна в области написания кода, где GPT-3.5 опережает ее, а GPT-4 значительно превосходит. Большие модели от OpenAI действительно являются значительным прорывом в этой области, поэтому это неудивительно.

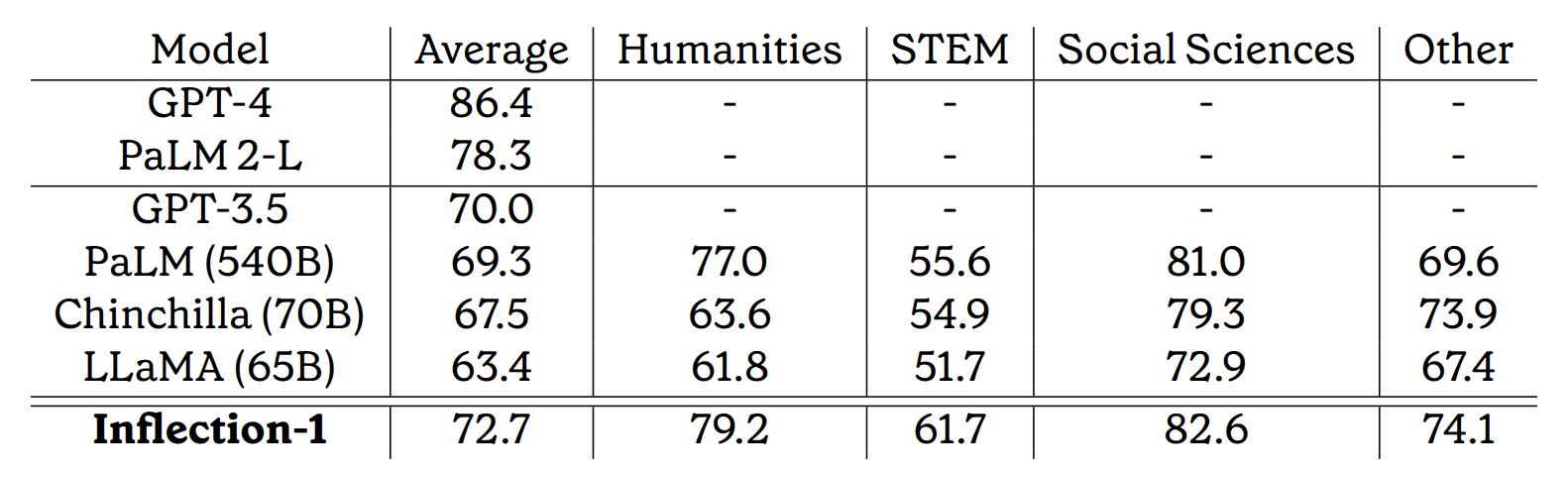

Бенчмарк MMLU

Massive Multitask Language Understanding (MMLU) — это широко используемая базовая метрика. Бенчмарк включает экзамены из 57 различных категорий, начиная от школьной и заканчивая профессиональной сложностью. Примеры вопросов доступны в документе.

По данному бенчмарку модель является наилучшей в своем классе, превосходя LLaMA от Meta, GPT 3.5 от OpenAI и PaLM 540B от Google:

Inflection-1 в среднем достигает средней оценки 72.7% по всем 57 задачам и точности более 90% на 5 различных задачах. На 15 задачах Inflection-1 достигает точности выше 85%. Для сравнения, эксперт-человек набирает в среднем 89.8%, в то время как средний человеческий оценщик набирает общую оценку 34.5%.

В Inflection отметили, что намерены опубликовать результаты работы более крупной модели, сопоставимой с GPT-4 и PaLM-2(L), но, видимо, результаты пока не достойны публикации, и потребуется некоторое время для дополнительной тренировки модели. Известно, что модель Inflection-2 или Inflection-1-XL находится на стадии разработки.