X-MeshGraphNet: фреймворк от NVIDIA для физического моделирования на основе графовых нейросетей

27 ноября 2024

X-MeshGraphNet: фреймворк от NVIDIA для физического моделирования на основе графовых нейросетей

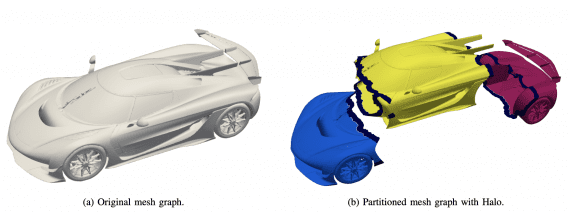

Исследователи NVIDIA представили X-MeshGraphNet, новое расширение для MeshGraphNet, которое значительно упрощает создание физических моделей и решает проблемы масштабируемости. Этот фреймворк позволяет создавать сложные физические модели, устраняя зависимость от предварительно сгенерированных…