Adobe Firefly 2 объединила модели генерации изображений и переноса стиля

11 октября 2023

Adobe Firefly 2 объединила модели генерации изображений и переноса стиля

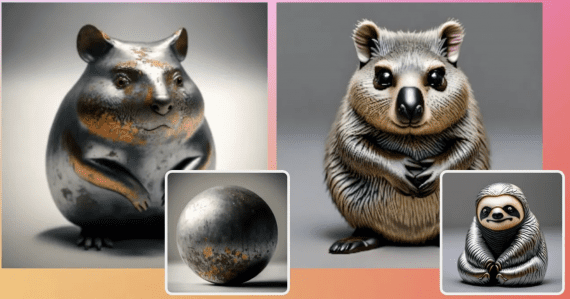

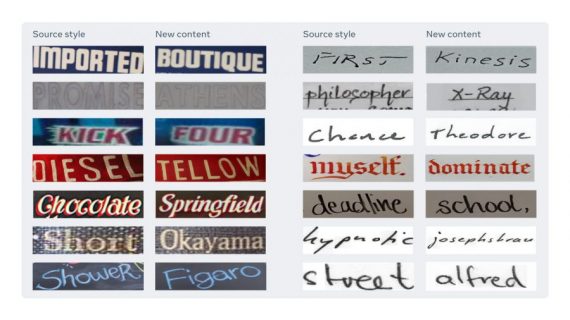

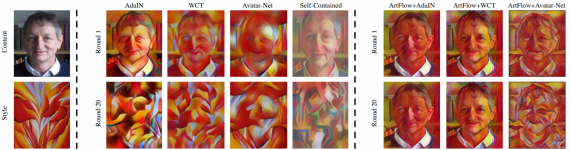

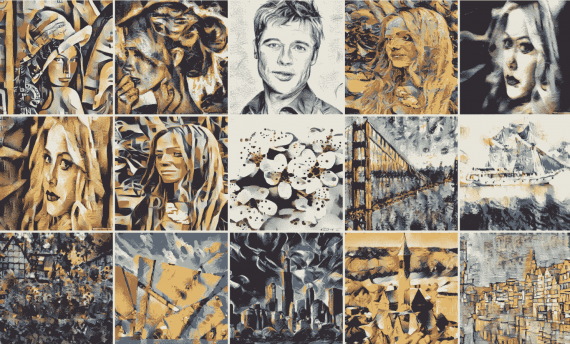

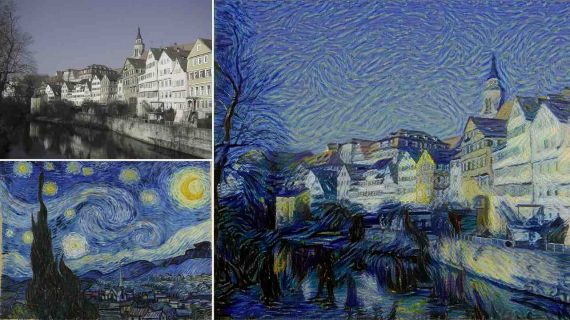

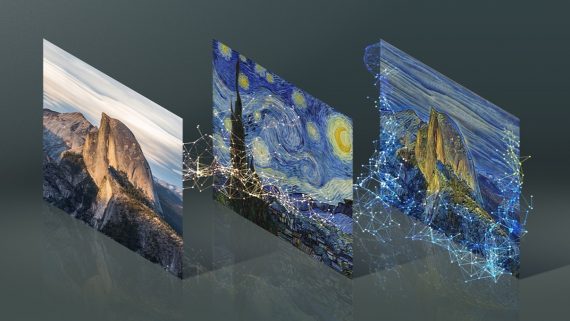

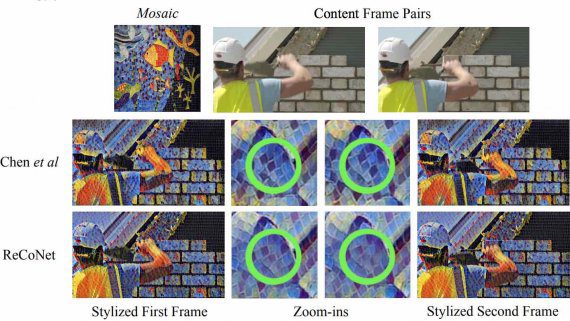

Adobe представила бета-версию модели для генерации изображений Firefly 2, соединяющую в себе функции text-to-image и style transfer. Инструмент Generative Match в Firefly 2 позволяет сочетать текстовые запросы с референсным изображением,…